自然語言處理「十項全能」挑戰

編譯/臺大電機系 吳奕萱

自然語言處理「十項全能」

自然語言處理「十項全能」(Natural Language Decathlon),目標是設計一個整合十項功能的模型 [1]:

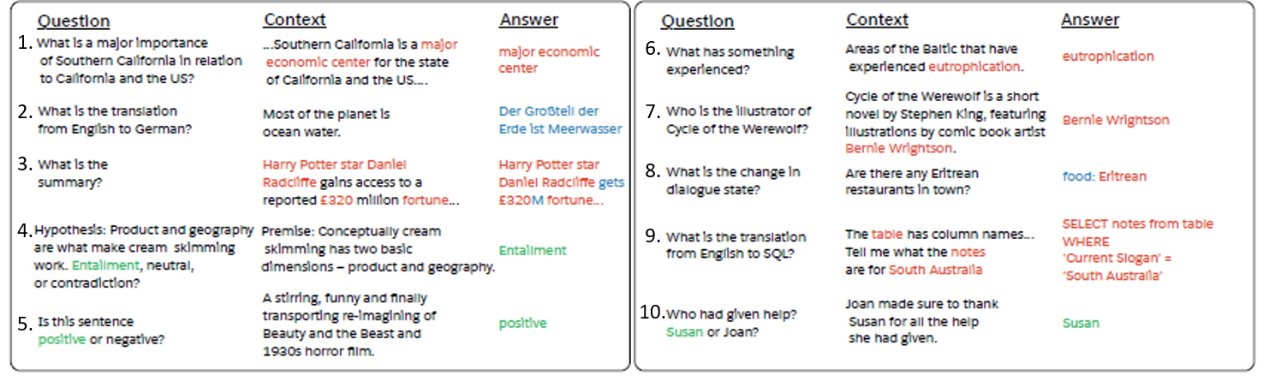

十項功能範例(圖片來源:參考資料[1])

圖中數字對應下方文字描述。「問句」是要執行的功能,模型要從「內文」中尋找答案。「答案」之紅字代表其為原文中的一段話,綠字為原文中的一個字,藍字則是模型根據對文本的理解生成的答案問答(Question Answering, QA):給定問題,從包含答案的資訊中找出答案

- 機器翻譯(Machine Translation):將文件由來源語轉換為目標語,以 BLEU 衡量翻譯精確度

- 摘要(Summarization):模型摘要文章的效能以 ROUGE(Recall-Oriented Understudy for Gisting Evaluation) 衡量

- 自然語言推理(Natural Language Inference, NLI):輸入兩個句子,分別為前提與假說,模型需判斷兩句的立場是相符、中立、或矛盾

- 情感分析(Sentiment Analysis):例如:對於網路上提到某個商品名稱的評論,判斷使用者抱持的觀點是正向、中立、或負面,以及是否具有購買意圖。藉由分析輿情了解大眾對商品的滿意度,並更能掌握個別客戶的需求與體驗,提升顧客服務的品質

- 語意角色標註(Semantic Role Labeling, SRL):給定一個句子與動詞,利用模型判斷「誰對誰做了什麼」,在什麼「時間」、「地點」發生。這一項可想像成有固定題型的問答任務

- 關聯萃取(Relation Extraction):從文章中找出主詞、受詞、與他們之間的關係,形成結構化的知識。關係的類別可以是角色、位置資訊、社會關係…等

- 目標導向對話(Goal-Oriented Dialogue):從使用者過去的行為與對話記錄,追蹤使用者對系統的預設目標以及互動中所展現的需求

- 語意剖析(Semantic Parsing):將自然語言轉換為機器可理解的形式,例如:結構化查詢語言(SQL)的語法。模型根據自然語言中的問題,生成對應的資料庫SQL語法,以找出相符的答案

- 代名詞解析(Pronoun Resolution):當句子中出現不只一個名詞時,將代名詞關聯至正確的名詞,例如:「蘇珊感謝貝蒂,因為她幫了她一個忙」,找出句中兩個「她」分別代表的人

每項功能分別以 F1、準確率(Precision)、召回率(Recall)等衡量。而衡量整個模型的效果,則是將每項的分數加總,得到0~1000之間的分數(每一項為0~100 分)。

相較於分別針對每項功能設計的模型,「十項全能」問答模型的好處是不用預設特定參數,便能學習以「問答」的形式達成多種自然語言處理的目標。這不僅代表我們不再需要分別為每項功能設計並優化模型,也意味著模型可以處理機器學習的「zero-shot」問題──面對訓練時沒有出現過的任務,模型也能迎刃而解。

問答模型:邊看題目,邊找答案

為了更精確解讀一段文字,Salesforce 研究人員提出了「動態關注網路」(Dynamic coattention network, DCN),根據輸入的問句,以最合適的方式「讀」一篇文章尋找答案 [3]。

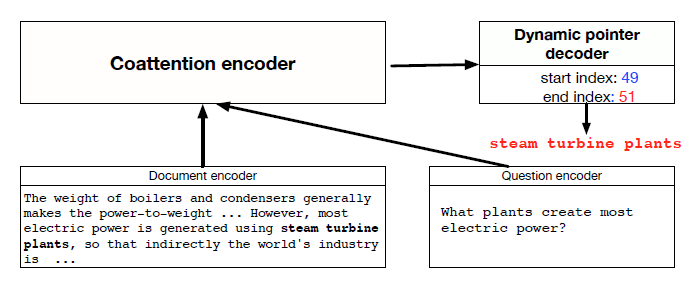

DCN 架構:編碼器與解碼器(圖片來源:參考資料[3])

DCN 的特色在於其編碼器與解碼器的設計:1. 綜合考量問句與文本內容的編碼器(Coattentive encoder)

編碼的精隨在於文本的特徵表示並不是固定不變的,而是因輸入的問句而異。這就好比我們做閱讀測驗時,若能看過題目再回文章找答案,將可更專注於與題目相關的資訊,降低答題的困難度並提升答對機率。Coattentive編碼器也依循這個概念,由文件內容與問句分別產生每個字的向量表示,為每個字計算權重,再將文件與問句字跟字間的關聯矩陣標準化後乘以權重,得到的向量相當於將問句投影到文件向量空間,綜合考量的結果。

2. 動態解碼器(Dynamic pointing decoder)

問答的答案通常是從文件中節錄的某段話,所以找答案的過程可以想像是尋找這段話最佳的「起點」與「終點」。尋找過程中運用兩個神經網路,計算每個字作為開頭或結尾之「分數」高低,多次重覆執行以尋找最佳答案。

整合式、持續學習的模型

語言是充滿彈性、能被靈活運用的媒介。同樣地,AI 也需要「靈活」的腦袋來解讀它。現今AI模型在自然語言處理個別任務上皆有不錯的表現,不過若要讓模型更流暢地對話,並理解文章前後文深層的意涵,則需要一個整合各項目標並「持續學習」的模型,以面對複雜度更高的挑戰。期待更多像「十項全能」這類整合不同類型任務的模型,引領人機互動世代的發展。

編譯來源

Richard Socher, “AI’s Next Great Challenge: Understanding the Nuances of Language”, Harvard Business Review (2018)

參考資料

- Bryan McCann, Nitish Shirish Keskar, Caiming Xiong, Richard Socher, “The Natural Language Decathlon: Multitask Learning as Question Answering”, (2018)

- Caiming Xiong, Victor Zhang, Richard Socher, “Dynamic Coattention Networks for Question Answering”, ICLR (2017)

- Victor Zhang, Caiming Xiong, “State of the art deep learning model for question answering”, Salesforce Einstein (2016)