AI也要金魚腦?

編譯/許守傑

哎呀,我忘了!

談到「忘記」這件事,可以說是人類大腦的一個特殊的現象。由於我們有著眼、耳、口、鼻、舌、皮膚等等各式各樣的感覺器官,無時無刻都在接收大量的信息並推送給腦部,處理起來相當耗費空間與能量。神經科學家透過研究後發現:為了保留重要資訊、減輕大腦負擔,「忘記」實際上是大腦的自動清理機制,透過定期清除大腦中的無用資訊使我們專注在更重要的事物上。更仔細的來說,當我們在忘記事情的時候,神經元間的突觸連結會隨著時間而減弱,甚至是消失,而且當新的事件發生時,新的神經元也會隨之發展並且重新建立大腦中海馬迴的迴路,覆蓋掉舊的記憶。因此,遺忘對我們有著積極的意義與功能,讓生物在做出決策時可以更有彈性,不用完全被過去的經驗所束縛。

然而,你可曾想過能夠不眠不休、過目不忘、有著十八般武藝的人工智慧,也需要開始學習像人類般忘東忘西嗎?!現在資料科學家們開始應用上述這些神經科學上的發現,來讓類神經網路學會如何像一樣人類「忘記」,以打造更有效率的模型。

人工智慧也會遺忘?

首先,科學家們認為AI其實也會「忘記」,只是它們遺忘的方式與人類大大不同。舉例來說,當我們教一個母語是英文的小朋友學習西班牙文時,他會利用學習英文時所學到的相關線索來套用在學西班牙文上,像是語言中相同的名詞、動詞、文法等等,而同時忘記口音、語調等這些不相關的部份;相對地,當我們想訓練類神經網路「說」英文時,統計模型會找出一組最適合英文這個語言的參數。然而當我們想教同樣的模型「說」西班牙文上時,統計模型依然會找出一組最適合西班牙文的新參數,但這組參數會完全地覆蓋原先那組英文參數,進而喪失已經學過的英文能力──這就是所謂的「毀滅性的遺忘」(catastrophic forgetting),而且也是類神經網路的基本限制之一。為了突破這樣的限制,目前科學家們發展出三種策略來克服這個難題:長短期記憶模型、彈性權重鞏固演算法與瓶頸理論。

長短期記憶模型

長短期記憶模型(Long Short Term Memory Networks,LSTM)是一種遞迴神經網路,透過獨特的結構,神經網路可以保有不定時間長度的記憶。LSTM中的三種控制閥(gate):輸入閥、輸出閥與遺忘閥,其中遺忘閥就專責於記憶或遺忘。譬如以看電影為例,電腦模型可以通過分析先前的場景來預測電影接下來會發生什麼事,然而如果當某個場景結束了,則模型就應該忘記此場景的資訊,因為結束的場景對後續劇情的預測已經沒有幫助了。因此,遺忘閥就可以為模型建立一個單獨的遺忘/記憶機制,且當得到了有助於未來預測所需的新資訊後,它必須知道該保留或丟棄已儲存的記憶。

彈性權重鞏固演算法

彈性權重鞏固(Elastic Weight Consolidation,EWC)是Google的DeepMind團隊在2017年3月研發出的演算法,該演算法模仿了生物神經突觸強化的過程。在這個過程中,我們的大腦會依據當前所需,選擇出數個關鍵神經元來執行任務,這些神經元之間的突觸連結會被強化(固化),以防止儲存在其中的記憶被覆寫。將同樣的概念套用在人工智慧上,EWC演算法會找出類神經網路中的關鍵連結,並且防止它們在訓練時被覆寫。

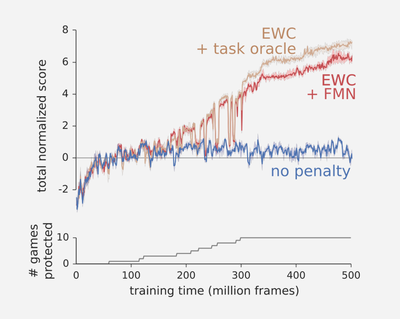

以擅長Atari遊戲的深度學習模型為例,相較於一般深度學習(藍色曲線),可以看出使用EWC演算法所訓練出的模型(紅色和棕色曲線)得分較高。(圖片來源:J. Kirkpatrick et al., 2017.)

瓶頸理論

在2017年秋天的一場演講中,希伯來大學電腦科學教授暨計算神經科學家Naftali Tishby提出了「瓶頸理論」(Bottleneck Theory),認為類神經網路在訓練時應該經過兩個階段:先學習再壓縮。在學習階段,類神經網路努力的掌握訓練資料的所有特徵;而在壓縮階段,類神經網路則丟棄相關性較低(對於完成指定任務比較沒有幫助)的資訊,僅留下最具代表性的資料特徵。這個過程就好像我們把酒由瓶中倒出,最後出來的才會是是沉底的佳釀,也就是最具代表性的資料特徵,而類神經網路正扮演著酒瓶的角色。通過這種方式,壓縮階段就像是一種策略性的遺忘,讓AI模型只記住最有效的資訊。

不論是長短期記憶模型、彈性權重鞏固演算法、瓶頸理論,這些新方法都讓目前的人工智慧模型又往前更進一步,而且當我們越來越了解大腦的運作原理與模式後,除了讚嘆大自然的奧妙之外,也讓人更期待這些跨領域的知識能為AI的發展帶來更多更有趣的變化!

編譯來源

N. Fratto, “Machine Un-Learning: Why Forgetting Might Be the Key to AI”, Medium, 2018.

參考資料

- J. Kirkpatrick et al., “Overcoming catastrophic forgetting in neural networks”, PNAS, 2017.

- N. Wolchover, “New Theory Cracks Open the Black Box of Deep Learning”, Quanta magazine, 2017.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)