自駕車肇事 誰的責任?

編譯/江彥成、黃思齊

一起自駕車致死車禍

2018年3月18日的夜晚,Uber的自駕車在亞利桑那州以時速約64公里的速度撞上了49歲的Elaine Herzberg。當時Herzberg正牽著自行車穿越公路,這起車禍最終導致了她的死亡。聯邦調查局在隨後的調查中透過車上黑盒子的紀錄,還原當時的情況:

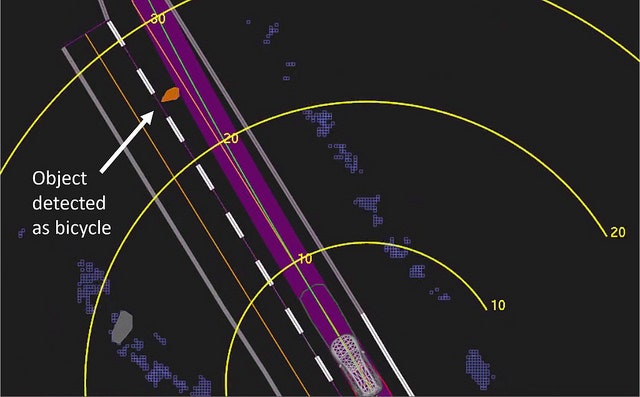

這台改裝過的Volvo XC90當時已開啟自動駕駛模式約19分鐘,雖然天色昏暗,但車上的感測器及光學雷達在撞擊前大約六秒即發現了Herzberg。由於她推著自行車橫越馬路,車上的AI先是將它識別為「未知物體」,再辨識為「車輛」,然後在「行人」、「未知物體」和「車輛」之間游移不決。每次判定都重新調整對它的行進預測,直到撞擊發生前一秒,自動駕駛系統判斷需要緊急煞車,不過Uber為了保護車上的人類駕駛,並不允許自動系統主動緊急煞車或大幅度急轉彎。此時唯一能挽救局面的,是當時在車中的人類駕駛Rafaela Vasquez;然而他正透過手機觀看《美國好聲音》(The Voice),最終導致了這場死亡車禍。

因車禍而身故的Herzberg,當時正推著一輛裝有塑膠袋的腳踏車橫向穿越馬路,這迥異於訓練資料的行為,導致Uber系統難以判斷前方的物體和他的行進方向,從而導致車禍。(圖片來源:Marshall, 2020.)

Vasquez被控過失罪(criminal negligence),Uber則安全下莊,除了在事發後迅速與Herzberg的家屬達成民事和解外,並未受到任何刑事指控。

2018年可說是無人車產業的多事之秋:Google母公司Alphabet旗下的無人車公司Waymo在亞利桑那州的測試期間,因為閃避不及,被違規闖紅燈的汽車撞翻。另外,Tesla在日本也發生一起死亡車禍:車上的駕駛正打著瞌睡,當前方車輛突然變換車道後,Model X 的自動駕駛系統未能及時察覺前方有事故發生,撞上了圍觀的群眾,導致致命的二次車禍。受害者家屬認為:自駕系統無法監控車上人類駕駛的精神狀況,也未能對突發狀況做出適當反應,是系統設計者Tesla在該起事故中應負的責任。Tesla並未回應這項指控,但從Uber事件的後續來看,可以預想最終的肇事究責可能也會止於人類駕駛。

Uber自駕系統的設計缺陷

當人類和機器共同肇事時,到底誰該負責、如何負責?這個問題在自動駕駛早已行之有年的航空業中,著實不是什麼新話題。只是許多年過去了,人類學家Madeleine Clare Elish在一份針對航空器自動駕駛系統事故的調查中指出:「法律上的責任認定與歸屬仍然沒有跟上技術的腳步」;相反的,身在事件當中的人——特別是在方向盤或儀表後的駕駛——經常替系統承擔了大部分的責任。

依據美國國家運輸安全委員會(National Transportation Safety Board,NTSB)針對此次事故所做的安全報告,除了人類駕駛的疏忽外,Uber所開發的自動駕駛系統至少存在兩項重大缺陷:

- 自動駕駛系統的規劃不夠完善;

- 遇到緊急事件時,過於依賴人類駕駛的決策。

現代的自動駕駛系統多仰賴於機器學習。AI模型是透過大量的圖像來「學會」辨識道路上可能出現的物體,例如救護車、機車或其他車輛。但實際會出現在道路上的,可不只是形形色色的「車輛」。橫穿馬路的風滾草、路邊1:1大小的汽車廣告看板、獨輪車,模型上路後,有很大的可能會遇到事前訓練時意想不到的物件。Uber當然也設想到這樣的可能,於是賦予人類駕駛在系統無法正確辨識前方物件時有更大的判斷與干預空間,但這樣的設計反而造成了更大的安全風險。

「人類是高度自動化系統的可怕管理者,航空、核電、鐵路工業歷史上的工程災難已經證明了這一點。」MIT研究人機互動的工程師Bryan Reimer毫不諱言地說道。90%的車禍可以歸咎於人為因素,光是美國境內每年便導致40,000人喪生。Uber卻奢望每小時24美元聘請的人類安全駕駛,可以在每次8小時的測試中肩負人車安全的重任。

自駕系統除了專注車外的路況,也應該具備監視車內駕駛的功能,比如監控駕駛員的視線,並且在分心時發出警告。凱迪拉克的半自動SuperCruise系統,就搭載了紅外線攝影鏡頭來觀察駕駛員的頭部位置,並在駕駛視線離開道路太久時發出警告。但Uber的系統不僅沒有監控人類駕駛,它甚至無法在緊急時向駕駛員發出警告。

面對多方指責,Uber表示在事故發生後已停止了大部分的自動駕駛測試,並聘請NTSB的前主席和航空專家Christopher Hart作為安全顧問。此舉卻影響了更多的人——Uber解雇了約300名雇員,其中大部份是隨車的安全駕駛。

責任分散效應

Google 早在2012年就開始了自駕車實驗,找了旗下員工在通勤路途上啟用自動駕駛功能。當時的功能仍較基礎,只有當員工駕駛的車輛駛入車流、穩定行駛後,才能開啟自動駕駛功能。Google特別叮囑每位參與實驗的員工:即使在自動駕駛功能開啟時,仍需百分之百保持專心。並在車內裝設了攝影鏡頭,用來記錄人類駕駛的試用情況。

試用迴響非常熱烈,所有參與者對自動駕駛系統十分滿意。只是當工程團隊回顧監控錄影時,卻驚訝地發現:多數人類駕駛都曾將注意力從方向盤上移開,甚至有人回頭在後座找了十分多鐘的充電器!自駕系統接手後,人類駕駛便不再時刻注意路況。

這是典型的責任分散問題:當兩個人同時被指派要負責同一件事時,雙方會傾向認為對方會注意,而疏忽職責。只是當合作對象是自動化系統時,人類的怠惰情況更為嚴重。畢竟,無時無刻專注路況,對人類來說是一項極易感到枯燥、乏味的任務。這類過度樂觀和信任的「自動化偏誤」(automation bias),也是自駕車亟待解決的安全問題。

Google於是認為人類不該和機器共享方向盤,並積極發展L4(第4級)的自動駕駛車輛。這是按照美國國家公路安全管理局(National Highway Traffic Safety Administration,NHTSA)與國際汽車工程學會(Society of Automotive Engineers,SAE)的定義所劃分的自駕車分級,由L0(第0級,完全手動)至L5(第5級,完全自動)共分6級。符合L4規範的自駕車,系統只有在極少數的特殊狀況下才需要人類駕駛的介入。

過時的法律規範

即使有朝一日能夠達到L5的全自動無人駕駛,仍有許多倫理問題尚待解決。比如典型的「電車難題」:無人駕駛車在路上行駛到一半,有一群人突然從馬路的一側衝出,若系統選擇迴避,可能會撞上旁邊的護欄導致車內的人受傷;而若不迴避,煞車不及的情況下可能會撞上前方擅闖馬路的人群。當你是車輛系統的工程師,你應該怎麼設定這個系統的邏輯?是撞上去?還是迴避?情況若反過來,你們一行五人乘坐的自駕車失控了,即將失速撞上前方的行人,這時又該如何選擇呢?

只歎現今的法律體系尚無法釐清自駕系統、系統設計者、第三方應用和人類駕駛之間的肇事責任歸屬,就更別提曲折的道德難題了!

編譯來源

A. Marshall, “Why Wasn’t Uber Charged in a Fatal Self-Driving Car Crash?“, Wired, 2020.

參考資料

- A. Marshall and A. Davies, “Uber’s Self-Driving Car Saw the Woman It Killed, Report Says“, Wired, 2018.

- E. Pettersson, “Bloomberg – Are you a robot?“, Bloomberg, 2020.

- Kurman and H. Lipson, Driverless – intelligent cars and the road ahead. The MIT Press, 2017.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)