用更少的資訊產生更好的影像──DeepFovea

編譯/賴佳昀

看到你想看到的

當我們在看外界事物時,由於人類視網膜中央的中央窩(fovea)上有著為數最多的(約六、七百萬個)視錐細胞,而後感光細胞的密度逐漸向外遞減,因此只有「注視點」(也就是成像在中央窩上的部分視野)周遭的景物會是清晰、高解析度的,而越靠近邊緣的視野則模糊不清。舉例來說,讀者之所以可以清楚閱讀這行文字,就是因為注視點專注於此,而在幾行之外的文字則無法被看清;不過,因為我們的大腦會自動填補邊緣視野欠缺的訊息,因此在生活中幾乎不會察覺到這樣的差異。然而這個現象除了生理構造上的限制外,還有另一項優勢:讓大腦每次只需專注在注視點的細節,更有效率地處理由周遭環境不斷湧入的視覺資訊。

節省多一點,顯示真一點

也因為這個原因,2014年「注視點渲染技術」(foveated rendering,或稱「注視點彩現技術」)首次被提出;2016年,便在美國消費電子展(Consumer Electronics Show,CES)中,正式應用於虛擬實境(Virtual Reality,VR)的頭戴式顯示器上。

由於VR仰賴電腦繪製體驗場景,使用注視點渲染技術生成,不僅可以大量降低電腦計算能力的要求,讓虛擬實境設備越來越輕便,還可以提升使用體驗,讓畫面更貼近人眼真實所見,同時減少疲倦、暈眩等不適感。

Facebook的研究團隊則在2019年底,針對注視點渲染技術提出一項新的變革。結合近期快速發展的生成對抗網路(GAN),開發出稱作DeepFovea的新模型。研究員先使用注視點渲染技術,以極少的資訊(大約10%的像素)生成影像全景,接著用DeepFovea填補、重建其中缺失的細節。不僅能讓生成的場景更逼真,也讓整體圖片壓縮更有效率、減少圖片傳遞延遲。

圖一、DeepFovea生成的圖片,先用約10%的像素以注視點渲染技術產生圖片(左),用GAN重建圖片中缺失的細節。(來源:Kaplanyan et al., 2019.)

清晰和模糊都要恰到好處

注視點渲染技術搭配眼球追蹤系統,是當前VR發展的趨勢。透過眼球追蹤,我們可以知道使用者正看向顯示器中的哪個位置,因此也可以分出注視點區域以及周圍區域。為了配合感光細胞在視網膜上的分布與大腦處理視覺資訊的特性,注視點區域的景物必須達到高清、高解析度,而在周圍區域則轉而追求穩定、不閃爍的影像。

Facebook研究團隊利用一系列的損失函數來達到不同的目的與圖像要求,例如:空間感知損失(perceptual spatial loss)對重建單幀圖像有所幫助;對抗損失(adversarial loss)明顯改善時間穩定性,也就是減少大部分的閃爍效果;光流損失(optical flow loss)則更進一步降低雜色訊。

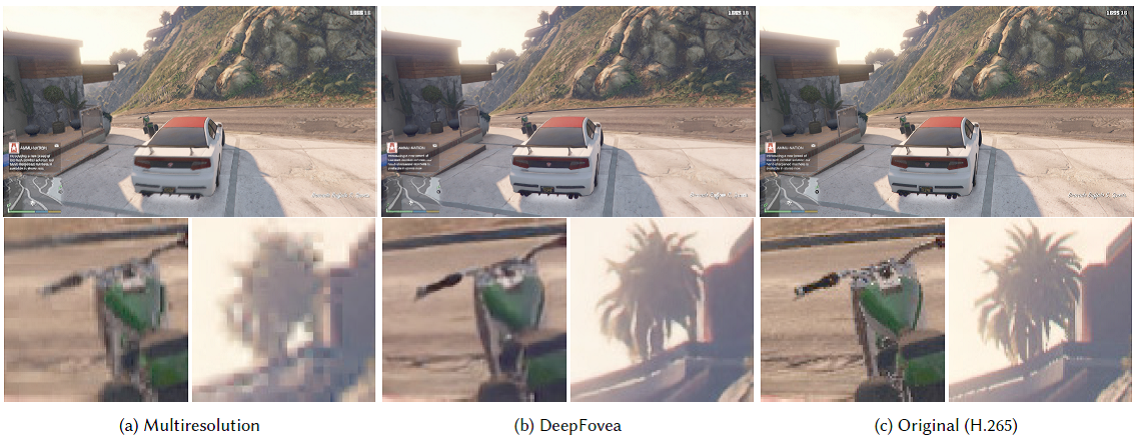

下圖是電玩遊戲「俠盜獵車手」(Grand Theft Auto)中一個較激烈的遊戲畫面,使用者的眼球注視畫面中央。兩種圖像生成技術──多解析度(Multiresolution)以及DeepFovea──都調至16倍壓縮,與標準H.265為基準做比較,可以看出DeepFovea不僅可以在一樣的壓縮率下重建更多細節,同時還減少了閃爍和飄移。

圖二、使用三種技術生成的遊戲畫面,包括多解析度(Multiresolution)、DeepFovea以及標準H.265。(來源:Kaplanyan et al., 2019.)

更輕巧的虛擬時代

Facebook研究團隊提出的新虛擬圖像生成技術,可以很穩定並有效率地從非常少量的輸入數據重建幾乎無損的全幀遊戲畫面,大幅降低渲染圖像所需的計算能力(約14倍)。

先前提過,造成使用者VR體驗不良的其中一項可能原因是暈眩,或許因為電腦生成的畫面全景過於清晰,導致大腦處理超過負荷;另一種可能,則是畫面延遲所致。設想現在一位遊戲玩家要迅速轉頭攻擊敵人,但由於畫面資訊量過大,電腦無法即時顯示,在半秒之後才出現新的對應畫面。如果玩家持續地轉頭變換視角,則動作和畫面就會一直不協調,進而導致玩家感到暈眩。這個問題凸顯了VR「輕裝上陣」的必要性,故而Facebook的研究成果相當重要。

VR頭戴裝置從有線到無線,再到追求舒適的使用體驗,隨著人工智慧不斷的發展,家家戶戶都有VR設備的日子或許也指日可待。

參考資料

- A. S. Kaplanyan, A. Sochenov, T. Leimkühler, M. Okunev, T. Goodall, and G. Rufo, “DeepFovea: neural reconstruction for foveated rendering and video compression using learned statistics of natural videos,” ACM Transactions on Graphics (TOG), vol. 38, no. 6, pp. 1-13, 2019.

- A. Patney et al., “Towards foveated rendering for gaze-tracked virtual reality,” ACM Transactions on Graphics (TOG), vol. 35, no. 6, p. 179, 2016.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)