內容審查怎麼進行?對網民們在網路社群上的行為有什麼影響?

撰文/楊期蘭(日本東京大學學際情報學)

內容審查的重要性

要維持一個線上社群穩定成長並保持活絡,好的內容審查機制是不可或缺的元素之一,因為線上平台們(例如:臉書社群、LINE的匿名聊天室、PTT的版、Clubhouse的房間等)需要控管平台內的內容品質,確保大家在裡面談論的內容不會有惡意中傷他人或色情暴力言論,同時也希望能夠鼓勵所有線上的使用者都可以儘量的貢獻「好」的內容,像是問切題的問題、回答別人的問題、分享相關且正確的資訊等,當一個線上社群裡面的人都可以生產好的內容,這個社群自然就有更高的機會可以穩定成長。

目前線上社群使用的內容審查機制有幾種:一種是直接由一群管理員們審查;一種則是運用機器人(bot)輔助版主或管理員來執行內容審查,像是先透過bot偵測到事先設定好的關鍵字,當有人的貼文中包含了這些事先列出的內容時,版主或社團管理員就會收到通知並人工確認一次;還有一種則是仰賴廣大網友們檢舉,透過bot整理過後,再交由人力確認審查。當一則貼文被刪除或是被檢舉的時候,有些平台會提供基本解釋,有些則不會提供任何解釋,這些違規的理由讓網民們知道的話,對網民們後續PO文行為會有影響嗎?

刪文後提供解釋 網民更了解社團規範

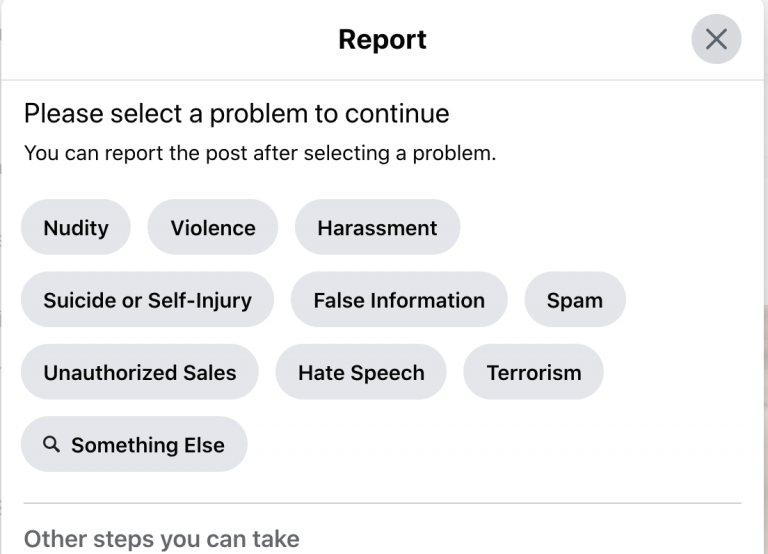

Facebook檢舉不當言論的回報頁面(圖片來源:截取自Facebook)

人機互動研究者針對Reddit(類似PTT的線上社群)分析發現,當網友們的貼文被檢舉或刪除後,有得到明確的違規說明,例如:詢問重複的問題、標題不含有問句、字數不符等,這些有得到說明的網友們後續貼文被檢舉或刪除的比例會顯著減少(相較於沒有得到解釋的網友),不僅是張貼文章的網友們可以知道自己違規的原因,那些有追蹤被檢舉文章的人也可以看到這些公開說明,進而了解哪些行為會被此社群認定為不合宜。藉由提供違規說明,網友們可以更加明白不同線上社群的規範,進而減少未來發生違規行為。

由Bot進行內容審核 更能鼓勵網友PO文

研究另一個發現是,當違規的解釋是由管理員提出時,收到檢舉的網友未來繼續PO文的比例會減少,但是如果網友收到的是來自於機器的檢舉,他們仍然願意繼續在這個社團中張貼內容;而使用機器人進行線上社群也可以減輕許多管理員的負擔,特別是在現今每天有這麼多網友們在不同的社群媒體上產出內容,運用機器進行自動化內容審查無疑是個好方法。

但是運用自動化方式執行內容審查來提供網友違規解釋時也更需要留心誤判的問題,過去也有研究指出當系統錯誤檢舉或刪除網友內容時,會嚴重影響網友們的使用體驗與對平台的信任感,因此設計出一個背後是由人與機器互相配合,但是最後是由機器給出內容審核的結果也許是個折衷方案,不但可以確保內容審查結果的準確度,也可以讓網友們在收到機器給的解釋後願意繼續在線上社群中分享內容。

參考資料

- S. Jhaver, A. Bruckman and E. Gilbert, “Does Transparency in Moderation Really Matter?“, Proceedings of the ACM on Human-Computer Interaction, vol. 3, no., pp. 1-27, 2019.

- S. Jhaver, I. Birman, E. Gilbert and A. Bruckman, “Human-Machine Collaboration for Content Regulation“, ACM Transactions on Computer-Human Interaction, vol. 26, no. 5, pp. 1-35, 2019.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)