AI的悄悄話大挑戰

編譯/臺大農藝系 林采萱

提取唇動資料

研究團隊以貼近真實生活的YouTube影片為材料,由長達14萬小時的影片中,過濾掉非英語發音、未拍攝到唇部的低畫質視頻,透過卷積神經網路(Convolutional neural network,CNN)辨識影像中說話者的唇部與口部動作,根據音位(phoneme)重新剪輯為可用素材片段,共4000小時的影像,包含逾127,000個英文單字。所產生的數據量,是以往相關唇語識別研究的七倍之多,對於神經網絡訓練來說,雖拉長訓練時間,卻也相對提升了系統準確度。

圖1、唇動影像 ( 來源:NewScientist )

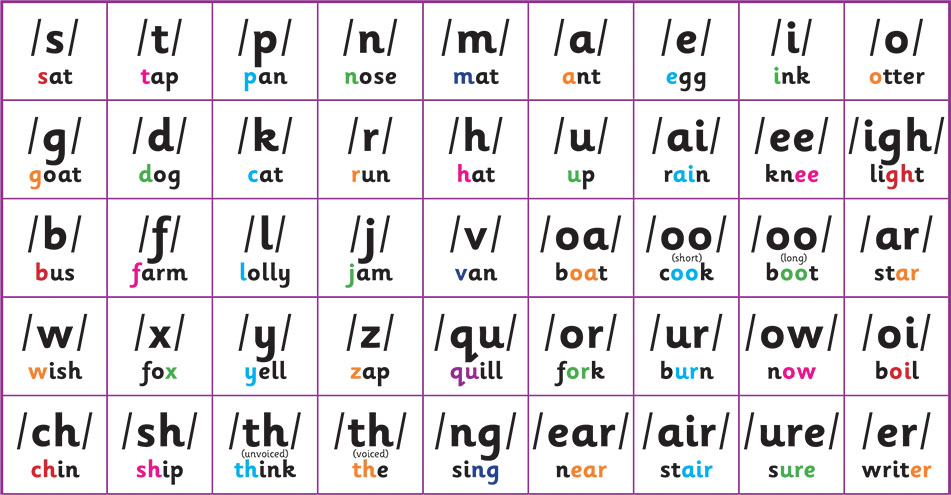

以「音位」為基礎

與過往不同,本次研究採用自然語言中能夠區別意義的最小發音單位─「音位」作為主要特徵參數,而捨棄常用的音節或單字。這樣選擇的好處之一,在於平時所說出的音節、單字,甚至是完整字句,都是藉由一系列固定的音位序列來達成。發出單一音位所牽涉的唇部動作,相對有限。藉由唇動影像辨識對應音位,再由音位序列推論出所對應的單詞與字句,雖然看似繞了遠路,卻也讓整體辨識系統有機會出現突破性發展。

圖2、英文中常見的44種音位 ( 來源:Rising Stars )

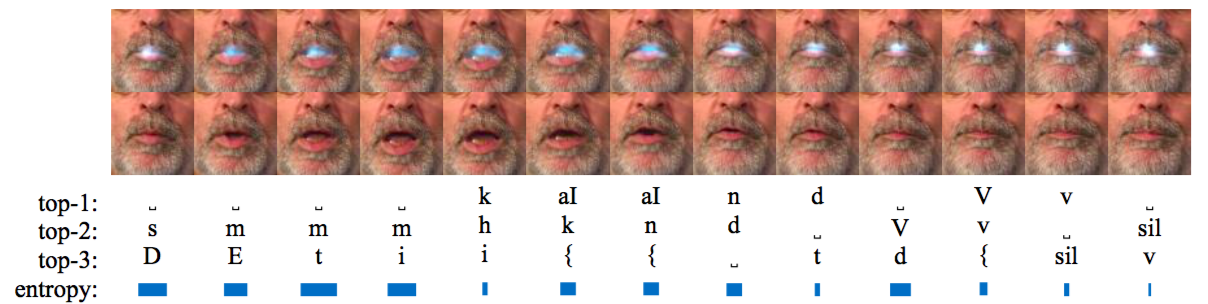

兩階段辨識模型

由於以音位為參數的模型十分龐大,為了加快效率與準確度,處理程序共分成兩個階段。第一階段,先採用連結時序分類(Connectionist Temporal Classification, CTC),根據每幀影格中的唇部動作(輸入端),來推測最有可能產生的音位序列(輸出端)。第二階段,才是將上階段所便識出的音位序列,轉譯為單詞序列,成為人類所能理解的語言陳述方式,成功建立「唇動影像—音位序列—單詞序列」的識別模型。

圖3、從每幀唇動影像預測最有可能的三種音位 ( Shillingford et al., 2018. )

此類模型的另一優勢,在於AI若需要學習新的字彙,人類僅需就第二階段的神經網絡重新訓練,也就是重新建立新單字與新一組音位的對應關係;而第一部分,也就是唇部動作與音位的對應,由於人類受到喉部與唇部構造的限制,所能發出的音位有限,則無需更動。

優於人類專家的識別能力

建立好神經網絡並接受訓練後,研究人員以37分鐘的影片來測試AI的實用性及準確度,雖然單字識別錯誤率高達41%,但已優於經過嚴謹訓練的人類唇語專家(錯誤率高達93%),以及現有其他以機器學習為底的唇語辨識系統(錯誤率達77%)。

儘管錯誤率仍有降低的空間,但此次研究無疑開啟唇動識別的新方向。預期若往後研究發展順利,將可整合AI唇語識別功能至智慧型手機中,成為聽障使用者隨身攜帶的翻譯機,或輔助串流影音聲音與字幕的同步,甚至應用於國家安全監控。

編譯來源

M. Hutson, “Lip-reading artificial intelligence could help the deaf—or spies“, Science/AAAS, 2018.

參考資料

- Shillingford, Y. Assael, M. Hoffman, T. Paine, C. Hughes, U. Prabhu, H. Liao, H. Sak, K. Rao, L. Bennett, M. Mulville, B. Coppin, B. Laurie, A. Senior and N. de Freitas, “Large-Scale Visual Speech Recognition“, Arxiv.org, 2018.

- J. Chung, A. Senior, O. Vinyals and A. Zisserman, “Lip Reading Sentences in the Wild“, Arxiv.org, 2018.