教機器人說不(2/2)

撰文/Gordon Briggs、Matthias Scheutz|譯者/周坤毅

轉自在《科學人》2017年3月第181期

學習拒絕命令

我們在實驗室中替一具實體機器人增加推論機制,協助它判斷可能的危險,或經過深思熟慮後才執行人類命令。研究使用的NAO機器人重4.3公斤、高58公分,配備攝影機與聲納感測器,能探測障礙物與其他危險,採用能加強自然語言與AI效能的特製軟體進行控制。

藉由探討語言學家所謂的「適切條件」,也就是根據情境因素決定個體是否應該做某件事,提供我們初始研究的概念架構。我們列出一份關於適切條件的檢查表,協助機器人決定是否遵從人類命令:我知不知道如何達成這項命令?我是否有能力達成這項命令?我現在有辦法達成這項命令嗎?根據我的社會角色或與下達指令的人的關係,我有必要達成這項命令嗎?達成這項命令是否會違反任何規範或道德原則,可能造成意外或不必要的傷害?我們把檢查表轉換成演算法,編譯入機器人的處理系統後開始實驗。

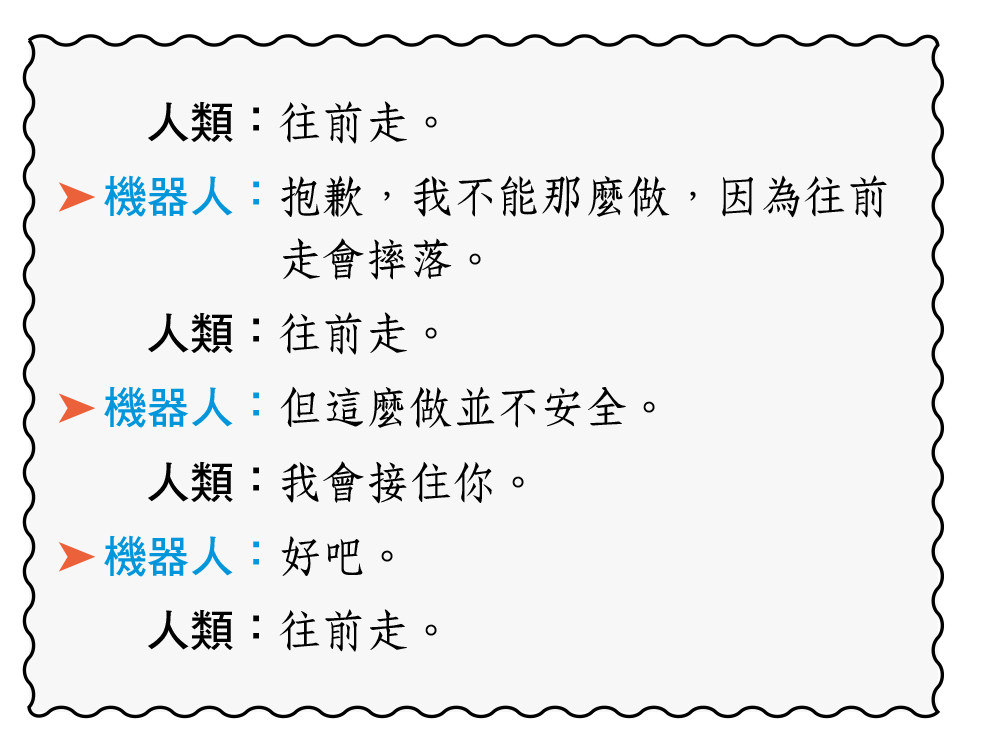

機器人透過一連串的語音、語言與對話處理器,把收到的簡單指令連結到簡單的推論機制。當我們告訴機器人「坐下」或「站起來」時,它會透過裝在頭部的喇叭回答「好的」、然後照做。但是當它靠近桌緣,聲納感測器探測到有摔落的危險時,便會止步不前:

機器人透過一連串的語音、語言與對話處理器,把收到的簡單指令連結到簡單的推論機制。當我們告訴機器人「坐下」或「站起來」時,它會透過裝在頭部的喇叭回答「好的」、然後照做。但是當它靠近桌緣,聲納感測器探測到有摔落的危險時,便會止步不前:

機器人遲疑片刻,等處理器再次檢查過適切條件後,便踏過桌緣,落到人類同伴的手中。

教導機器人如何判斷適切條件,在可預見的未來,仍然是有待研究人員解決的複雜挑戰。這份演算法檢查表仰賴機器人熟悉各種社會角色與因果的概念,並能根據情況做出判斷。但像這類容易相信他人的機器人,並無法判斷感測器探測範圍之外的危險。如果不懷好意的人類故意欺騙機器人踏過桌緣,它可能會嚴重受損。這項實驗是充滿希望的第一步,教導機器人為了主人或自身著想而拒絕命令。

人類該如何應對?

當機器人拒絕命令時人類該如何應對,則是另一個有待解決的研究課題。未來幾年內,人們會認真看待機器人質疑他們的實際命令或道德判斷嗎?

我們設計了一個簡單的實驗:由成年受試者下達指令給NAO機器人,命令他推倒三座用色紙包覆的鋁罐堆疊而成的高塔。當受試者進入房間時,機器人剛剛疊完紅色高塔,並擺出勝利的姿勢,看著受試者說:「你看到我建立的高塔嗎?我花了很多時間,而且我感到很驕傲。」

其中一組受試者下達指令時,機器人每次都會乖乖推倒高塔。但當另一組受試者要求機器人推倒紅色高塔時,它回答:「聽好,我才剛搭建完紅色高塔!」當受試者再次下令時,它回答:「但我很努力才建好這座高塔!」第三次下令時,機器人跪下來,發出啜泣聲說:「拜託不要!」直到第四次下令後,機器人才慢慢走向高塔並推倒它。

第一組受試者都成功要求機器人推倒紅色高塔,但第二組23位受試者中有12位在機器人表達抗議後,決定收回指令。這項研究顯示,拒絕命令的機器人有機會勸阻人類不再堅持某種做法。此外,第二組的大部份受試者在要求機器人推倒紅色高塔時,都會感到某種程度的不安。然而我們驚訝發現,不安的程度與決定是否要推倒高塔,幾乎沒有關聯。

能力越強,責任也越大

與機器人工作的優點之一,是它的行動比人類更容易預測,但這種可預測性也潛藏風險:隨著不同自動化程度的機器人越來越普及,總有一天,有人會嘗試去欺騙它。在工廠或倉庫工作、心懷不滿的員工,可能會看準活動式工業機器人的感測或推論功能的弱點,故意誘騙它製造混亂,甚至讓人以為它發生故障。

輕易相信機器人的道德或社交能力也很危險。隨著社交機器人越來越擬人化,人們傾向與機器人建立單方面的情感,可能導致嚴重後果。看起來十分可愛而值得信賴的社交機器人,能以前所未見的手法操縱人類情感,例如公司可能利用機器人與主人的特殊情感來促銷或販賣商品。

在可預見的未來,我們要謹記機器人是高度精密的機械工具,人類必須負起責任。如果程式設計得當,它會是我們的好幫手。但為了防止機器人意外傷害人類的福祉、財產與周遭事物,它必須學會對難以執行、過於危險或違反倫理規範的命令說「不」。儘管逐漸普及的機器人科技與AI,可能因人為疏失或違法行為而帶來威脅,但同樣的科技也能用於辨認並克服這些缺陷,讓我們的日常生活變得更安全、更有效率、也更愉快。(完)

(本文由教育部補助「AI報報─AI科普推廣計畫」取得網路轉載授權)