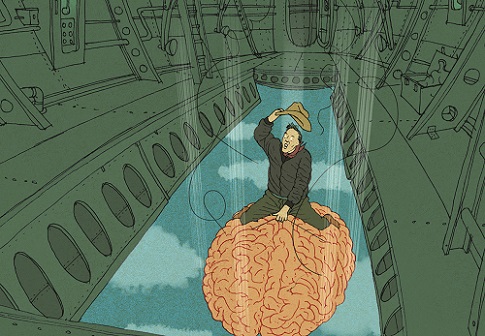

AI末日仍有解

撰文/Michael Shermer|譯者/潘震澤

轉載自《科學人》2017年4月第182期

2014年,太空探索科技公司執行長馬斯克在推特發文:「伯斯壯的《超級智慧》值得一讀。我們必須特別留意人工智慧(AI),其潛在危險比核彈更大。」同年,英國劍橋大學宇宙學家霍金對英國廣播公司(BBC)說:「AI的全面發展可能終結人類。」微軟的共同創辦人蓋茲也提出警告:「我隸屬於擔心超級智慧的陣營。」

電腦學家尤考斯基在2008年《全球性災難風險》條列了AI末世錄將如何展開:「AI有多大的可能性,跨越阿米巴原蟲與無知鄉民之間的巨大鴻溝、最後止於人類天才的層面?」他的答案是:「我們有可能製造出計算能力比人腦快百萬倍的腦……如果人類心智也能以相同速度運作,那麼倘若原本要花上一整年思考,就只需31秒鐘;1000年將變成在八個半小時內快速飛過。」尤考斯基認為,如果我們現在不能控制這一點,時間將不等人,「AI躍進的時間尺度與你我不同;等到你的神經元想清楚『我應該做點什麼』時,你已經輸了。」

這種想法可由英國牛津大學哲學家伯斯壯在其著作《超級智慧》中提出的想像實驗為代表:迴紋針最強製造者。該實驗假設有某個專門設計用來製造迴紋針的AI,當它把最初供應的原料用完後,就會用周遭任何可取得的原子(包括人類)來製造迴紋針。伯斯壯在2003年發表的論文中描述如下:該AI「一開始會把整個地球變成製造迴紋針的設備,然後擴展到部份太空」,不出多久,整個宇宙就變成了迴紋針及製造迴紋針的設備。

對此,我持懷疑態度。首先,所有末日場景都包含一長串「如果-那麼」的可能事件,只要其中任何一個環節出了問題,末日危機就會解除。西英格蘭大學電機系教授溫菲爾德在2014年的一篇文章寫道:「如果我們成功製造了與人類智慧相當的AI,如果該AI取得了運作的所有知識,如果它又成功改良了自己、製造出超級聰明的AI,如果該超級AI不小心或惡意開始消耗資源,如果人類沒有及時阻止,那麼,沒錯,我們可能會有麻煩。這種風險不是沒有,但不大可能。」

其次,AI的發展比預期慢上許多,我們在每個階段都有時間加以阻止。一如Google執行長施密特回應馬斯克及霍金:「難道你們不相信人類會注意到這種事?難道你們不認為人類會設法把這些電腦關掉?」Google旗下的「深度心智公司」就發展了AI開關的觀念,以便在AI試圖接管時按下去,他們還開玩笑稱此開關為「大紅按鈕」。百度的副總裁吳恩達則是這麼說的(戳了馬斯克一下):「這就好比我們還沒踏上火星,就開始擔心火星的人口過多問題。」

第三,AI末日場景的預測經常根據「天生智慧」與「人工智慧」的錯誤類比。一如去年美國哈佛大學的實驗心理學家平克針對Edge.org網站的年度問題:「你對於會思考的機器有什麼看法?」所做的回答:「AI反烏托邦說法把狹隘的大男人心理投射到『智慧』的觀念上。他們假定,超越人類智慧的機器人會發展出打倒主人或征服全世界之類的目標;但同樣可能的是,AI會朝著能充份解決問題、沒有意願濫殺無辜或征服文明的女性思維方向發展。」

第四,說電腦會「想要」做某件事(例如把世界都變成迴紋針),代表AI也有情緒。但科學作家柯羅斯特提出:「一旦AI開始想要某些東西,它就活在獎懲的世界;包括它會因行為不端而受到人類處罰。」

有鑑於末日預言迄今為止的零成功率,加上AI數十年來的緩慢成長,我們有充份時間建立萬全系統,以防止任何這種AI末日的發生。

(本文由教育部補助「AI報報─AI科普推廣計畫」取得網路轉載授權)