【探索26-1】公共化AI:你我可以做什麼

講者/國立清華大學通識教育中心&人文社會AI應用與發展研究中心 林文源

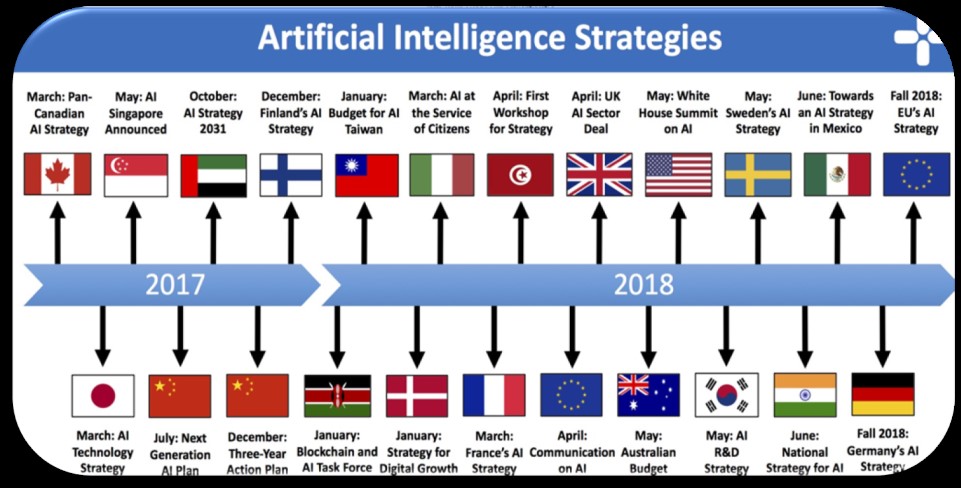

AI是當前方興未艾的新科技趨勢,面對AI我們需要有更多的想像,以免只是跟著資本化與技術發展的興趣,隨波逐流。這種想像有許多層面,包括一個國家如何想像其AI戰略。

如果我們不只是將AI當成一個產品,並被動地期望其無所不能或悲觀地恐懼其對社會的危害。從實際上AI做為各種重新安排科技與社關係的系統或體制的角度,我們如何想像AI如何與社會共存、AI能做什麼或無法做什麼,以及我們每個人如何想像我們可以如何參與AI的協作,讓AI更好。有機會加強AI的公共性。

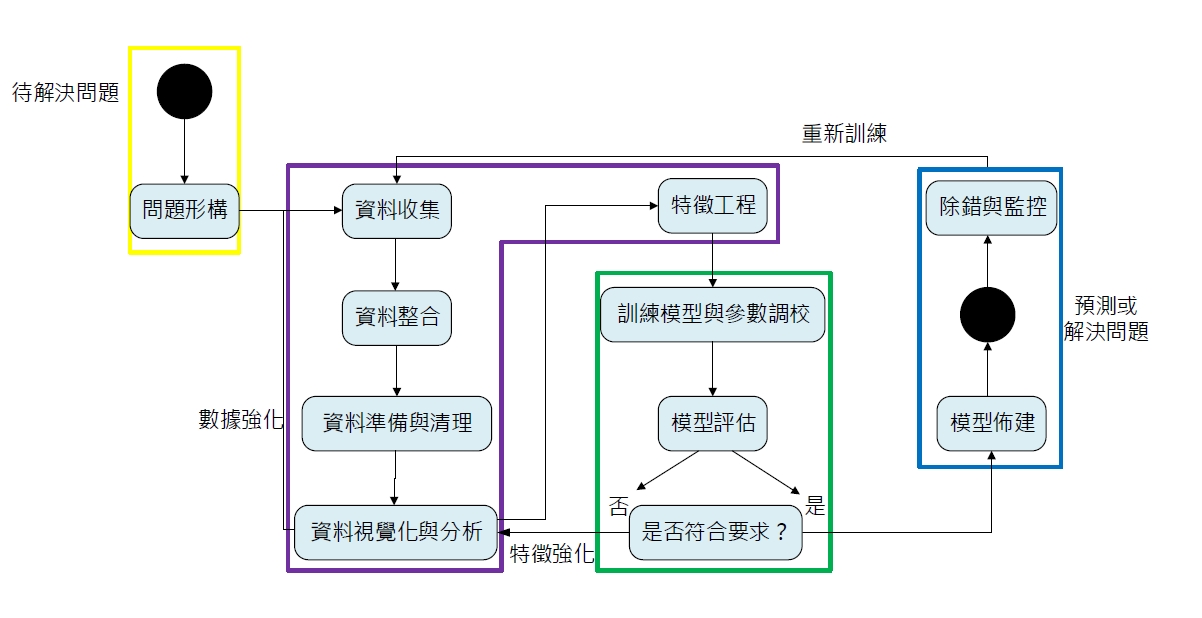

這是本次分享的主軸。如果由AI實現流程來區分,以監督式學習的流程來看,公共化AI可以區分為四個大面向,包括問題架構、大數據、演算法、詮釋與應用四大面向。而公共化AI的幾個關鍵包括可以用以下簡單方式提問:1、誰的問題?2、誰的資料?3、誰的詮釋與應用?4、誰參與協作?[1]

其中,首先是框架問題過程,亦即因為哪種需求或問題意識,因此收集、整合哪些資料,並以特定方式整理並清理資料,作為AI學習的基礎。其次,是資料整理與標註,亦即我們常說的大數據(big data)。事實上,各種數據都可能作為機器學習的基礎,但這些資料若為經過適當分析與處理,有無數偏見與誤用在一開始就影響AI的可信度與客觀性。進一步,是機器學習的演算法核心。不同演算法的設計、程式特質或軟硬體資源,會影響其準確率,最重要的是我們以哪種角度標示資料,如何以最佳化的演算法與參數調整,找到最適當的結果。而這些背後自然有不同技術生態與社群。最後,是AI詮釋與應用。這一般並未被視為AI技術的一環,但是由其社會影響或行動網絡過程卻是必然存在的,亦即AI還是必須經由詮釋與應用,嵌入制度決策而造成社會影響。

在這些過程中,如果發揮想像力,我們可以用以下方式設定一些問題,對AI提問,找到我們能夠參與AI協作的方式。因此,以下我們不給答案,而是舉例提出如何提問。

一、問題架構:例如,以目前許多公共服務都開始使用AI輔助來看,我們可以提問,這是誰的公共服務?從服務端來看,我們可以思考加入AI的目標是效率?人力?品質?等待時間?被回應的感覺?而從使用端來看,加入AI是否加重不平等與落差?例如,現有公共資源的無障礙空間、數位落差問題,是否會因為AI加入增加或減少進一步的AI門檻:哪些AI能做?哪些無法做?由誰的角度做?哪些AI會惡化現有落差?而這也必須重新界定公共服務的宗旨為何?

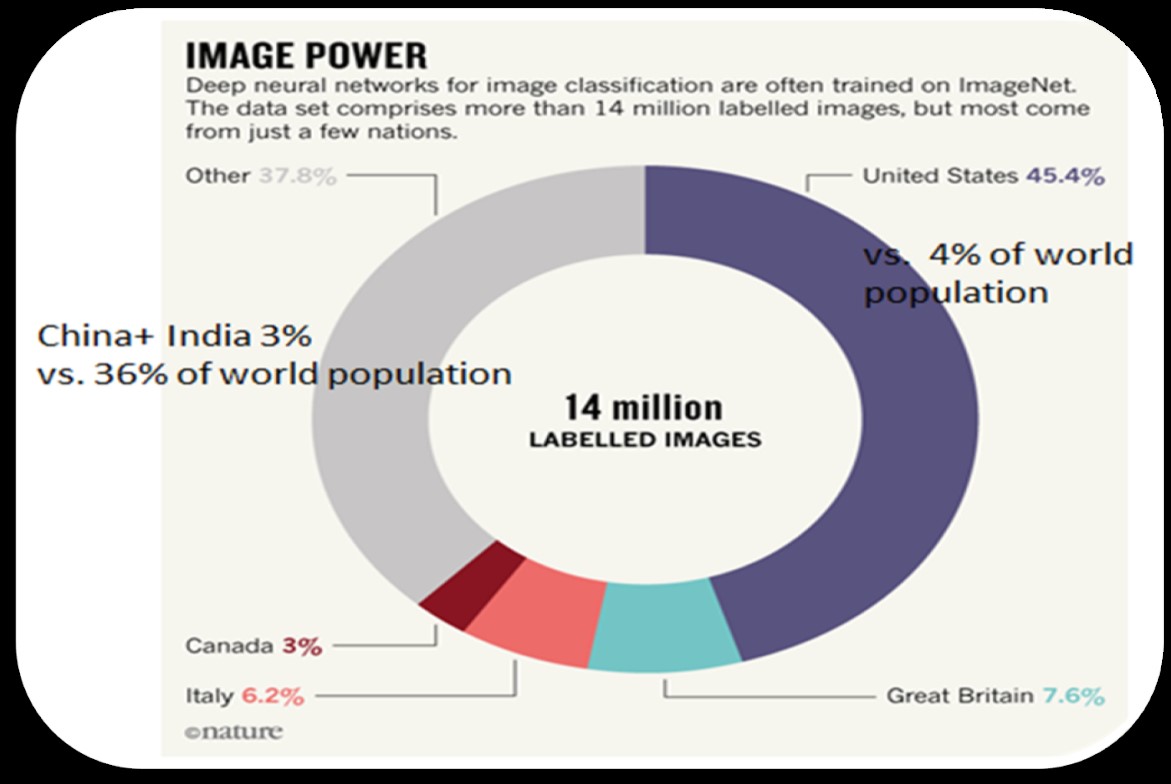

二、大數據:例如,是誰的資料?AI的判斷來自其標註後的資料的訓練,因此資料來源、品質、脈絡、是否具有特定分布,能否應用於其他脈絡的資料?都是重要的問題。舉例來說,在著名科學期刊 Nature 的一篇文章指出「AI可能性別歧視與種族歧視」(AI can be sexist and racist — it’s time to make it fair)

因為許多AI視覺訓練資料來自Imagenet,而其中多數資料45.5%來自美國,但其人口只佔全球人口4%,但是更為多數的人口與國家如中國與印度加起來佔36%,但在其中的影像資料只有3%。因此,由此訓練的AI往往如同美國中心主義的視野一般,成為「文化盲」(cultural blind),誤判其他種族的資料。

三、詮釋與應用:AI只是一種軟體,其預測或判讀結果要發揮作用,都必須融入現有的制度或社會安排。在這些安排中,我們必須同樣如同對資料的提問一般,小心地檢視:AI訓練的資料來源、品質、脈絡、其訓練模式是否具有特定分布,能否應用於其他脈絡的判讀?是否有其他背景或問題脈絡需要進一步考量。例如,如果醫院管理AI判斷一位病患預後較為不佳,這是純粹臨床資料判斷?或是加入病患背景、社會經濟條件判斷?(經濟條件不佳容易延誤就醫)或是加入醫院介入差異的判斷(不同經濟條件選擇使用治療方法、時間長短、療效可能有差異)?更重要的是是否可能因為忽略AI的限制自我證成的預言,忽視為納入訓練資料而導致AI無法判斷的因素(如社會背景),反為AI所誤導,導致進一步的惡性循環。

四、參與協作:儘管不是每個人都應該或有能力參與演算法開發或應用,但是,我們能夠思考「誰的技術?」「誰參與協作?」意思是,擁有演算法技術者是AI技術的專家,但還有各種專家:各種有志參與AI協作者,除了可以是居民、病人、學生、公民等「需求的專家/當事人」,還有「參與現場的專家」如教學AI的教師、公共服務AI的社工;「資料的專家」與「制度的專家」如瞭解各種資料分析與盲點,還有AI進入制度的問題與長處的人文社會研究者;「理念的專家」例如倡議各種價值的NGO等。如上所述,AI的各種環節都需要關注與投入,現有各種黑克松(hackathon) 與開發社群都是這種類型,這也有助於讓技術不只侷限於技術思維,更具開放性地結合多方需求與協助。

上述提問方法只是一些例子,從將AI視為重組科技與社會安排的系統,以及如何參與協作的角度,我們每個人都有機會參與AI公共化。期望大家都能一同參與想像AI。

--

註[1] :進一步對AI相關流程的導論介紹請見:「人社AI導論」https://www.youtube.com/playlist?list=PL_qamH512zu6NbUEDShUFyHiE7qHUGJiN

(本文為教育部「人工智慧技術及應用人才培育計畫」