AI需要新版涂林測試

撰文/John Pavlus |譯者/周坤毅

轉載自《科學人》2017年6月第184期

溫諾格雷基模挑戰

以AI先驅溫諾格雷命名的溫諾格雷基模,是由簡單但語意不清的自然語言構成的問句。正確回答這類問題,必須具備對真實世界中各種介質、物體與文化規範如何互相影響的基本常識。

溫諾格雷在1971年寫下的第一個基模,描述「市政府拒絕示威者的申請,因為他們擔心暴力行為」,接著問一個簡單問題:「誰擔心有暴力行為?」這稱為代名詞歧義消除問題(PDP)。在這個問題中,「他們」指的是誰並不明確。但溫諾格雷基模比其他PDP更難以捉摸,因為只需改變一個詞,整個句子的指稱詞便完全相反,例如「市政府拒絕示威者的申請,因為他們鼓吹暴力行為」。大部份人利用「常識」或對「真實世界的了解」判斷市政府與示威者的關係,來回答這類問題。這項挑戰先用簡單的PDP進行淘汰賽,通過第一輪測試的系統,才會接受真正的溫諾格雷基模挑戰。

優點:由於電腦缺乏溫諾格雷基模所需知識的可靠來源,這項挑戰能防止電腦靠網路搜尋來作弊。

缺點:可用的溫諾格雷基模詞句庫相對較少。美國紐約大學的電腦科學教授戴維斯指出:「想出這類句子並不容易。」

困難度:高。在2016年有四套系統回答60個溫諾格雷基模問題。優勝電腦的正確率只有58%,遠低於研究人員設定的90%門檻。

應用範圍:這項測試能分辨電腦是否真的理解語意,還是只會模仿。與戴維斯共同研究溫諾格雷基模挑戰、任職於雷多斯公司的研究員摩根斯坦解釋:「蘋果的語音助理Siri無法理解代名詞或消除歧義。因此當你說到前一個句子中的指稱詞時,對話便無法繼續下去。」

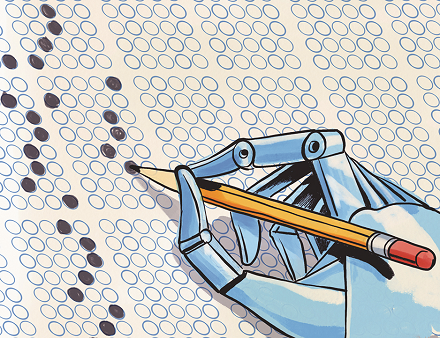

標準化的學科測驗

在沒有任何協助之下,AI將參加美國小學與中學生的標準化教育筆試,以評估是否具備連結事實與語意認知的能力。就像涂林原版的模仿遊戲一樣,這項測試非常直截了當:只要拿任何足夠嚴謹的標準化學科測驗,例如紐約州小學四年級科學測驗中的選擇題,並替電腦裝上能讀取測驗材料的自然語言處理器與電腦視覺裝置,便能進行測驗。

優點:變化多端且十分實用。有別於溫諾格雷基模,這項測驗的材料既便宜又容易取得。此外,由於測驗材料並未針對機器進行修改或事先處理過,光是分析問題便需要對真實世界有豐富的多方面常識,更甭說能夠正確回答。

缺點:無法像溫諾格雷基模一樣,防止電腦藉由網路搜尋作弊。而且如同參加考試的人類,通過標準化測驗並不代表真正的智慧。

困難度:中高。艾倫人工智慧研究所設計出一套系統「阿里斯托」(Aristo),在第一次參加四年級科學測驗中,拿下平均75%的分數,但這只是不包含圖表的選擇題。該所的研究人員在發表於《人工智慧雜誌》上的論文中寫道:「目前沒有任何系統能通過完整的四年級科學測驗。」

應用範圍:執行真實性檢查。艾倫人工智慧研究所的執行長伊茲奧尼(Oren Etzioni)表示:「基本上,我們沒看過任何程式能在中學八年級科學測驗中拿到超過60%的分數。在此同時,媒體卻報導IBM的超級電腦華生(Watson)正就讀醫學院並試圖解決癌症。要嘛IBM已取得驚人的重大突破,要嘛就是誇大其辭。」

實體化的涂林測試

大多數電腦的智慧測試都強調認知,但這項測試比較像實作課程。AI必須用有意義的方式,實際操作真實世界中的物體。測試包含兩個項目:在建構項目中,實體化的AI(基本上就是機器人)得遵照口頭、文字或圖片中的指示,把一堆零件組成特定結構,就像組裝IKEA家具一樣。探索項目則要求機器人利用玩具積木,設計解決方案來克服開放且更需要創意的挑戰,例如築牆、建造房屋或加蓋車庫。測試的重頭戲是最後的溝通挑戰,機器人必須解釋為什麼這麼做。測試對象可以是單一機器人、一群機器人,或與人類合作的機器人。

優點:這項測試整合了感官與動作兩種真實世界的智慧,這是過去被忽視或研究不足的領域。此外,這項測試幾乎不可能造假。紐昂斯溝通公司的奧蒂茲表示:「除非有人想出如何把任何東西的組裝說明書放上網路,不然我很難想像機器人如何作弊。」

缺點:除非讓機器人在虛擬實境(VR)中建造結構,否則相當麻煩、乏味,而且很難自動化。奧蒂茲說:「即使如此,機器人學家會說VR只是近似值。在真實世界中,當你撿起物體時可能會滑落,或得注意其他細節;虛擬世界很難忠實模擬出這些細微差異。」

困難度:只出現在科幻小說中。實體化AI若能操作物體、並條理清楚解釋為什麼這麼做,基本上跟電影「星際大戰」中的機器人一樣,遠超出目前的科技水準。奧蒂茲說:「要求機器人做到人類小孩就能完成的日常小事,仍是巨大挑戰。」

應用範圍:整合感官、動作、認知和語言,四項全能的AI是鑽研單一能力的研究人員的夢想。

電腦奧林匹克

在一連串部份或完全自動化的測試中,AI必須總結出語音內容、敘述一段影片的情節、即時翻譯自然語言,並執行其他任務,為的是建立客觀的智慧評量指標。這項測試的特點是測驗與評分將完全自動化,不需人類介入。把人類排除在評估AI的程序外,看似有些諷刺,但IBM的AI研究員、研發超級電腦深藍(Deep Blue)成員之一的坎貝爾(Murray Campbell)指出,為了確保效率與再現性,這是必要的。他表示,利用演算法自動替AI評分,研究人員不必仰賴人類智慧(可能出現認知偏誤)做為衡量標準。

優點:至少在理論上完全客觀。裁判只需決定各項測驗的評分方式與結果的權重,電腦便能自動完成評估。結果應該像奧林匹克終點線的裁定照片一樣沒有爭議。多樣化的測驗也能協助找出IBM研究人員所謂的「一般性智慧系統」。

缺點:結果難以評斷。電腦奧林匹克的演算法可能會給某種AI系統高分,但研究人員無法完全理解其運作方式。坎貝爾承認:「先進AI系統所做的某些決定,可能很難用簡潔易懂的方式向人類清楚解釋。」研究卷積神經網路的研究人員便已經遇到稱為「黑盒子問題」這類困境。

困難度:視情況而定。目前系統在某些測驗中表現良好,例如理解圖片或翻譯語言。但敘述影片內容、根據口頭描述繪出圖表等這類任務,仍然停留在科幻小說的範疇。

應用範圍:在評估AI時,減少受到人類認知偏誤的影響。除了分辨AI外,還能量化其效能。

(本文由教育部補助「AI報報─AI科普推廣計畫」取得網路轉載授權)