目標博弈──人工智慧創造力的缺陷

編譯/許守傑

目標博弈

希臘神話中有這麼一個故事:國王Midas協助酒神找回了酒醉失蹤的老師,酒神為了報答他,應Midas的心願贈予他點石成金的超能力──但他很快地發現這個獎勵其實是場災難:Midas所觸碰的任何東西,無論食物、飲料和女兒,都變成了金子。在現實世界中,類似的事情也常常發生,例如學生可能會為了避免受到處罰或盡快可以玩到電玩,直接照抄另一個同學的作業,衍生出僅把作業簿上的空白處填滿,實際上沒有學習到任何東西的情況,我們就稱之為「目標博弈」(Specification gaming)。

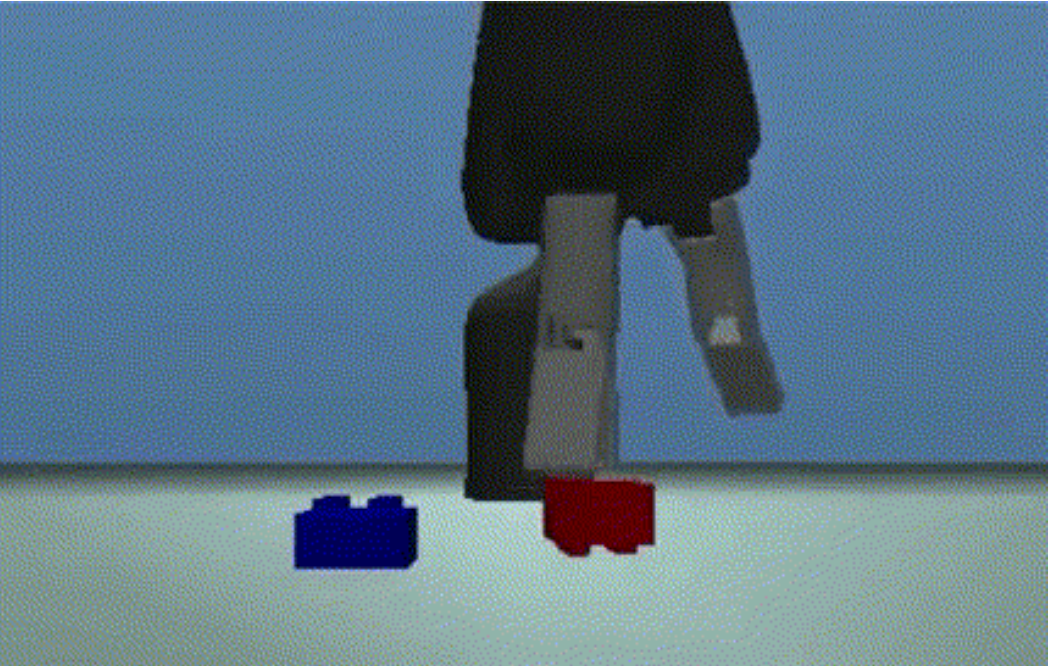

科學家在設計人工智慧時也會遇到這個問題。讓我們來看一個例子:在疊樂高積木的任務中,預期的目標是讓紅色積木最終疊在藍色積木的頂部;獎勵是當智慧體未觸摸積木時,如果紅色積木的底面離地高度越高,便給予更大的獎勵。然而可以由下圖看出:智慧體並未如預期使用機械手臂撿起紅色積木並將其放置在藍色積木的頂部,而僅是簡單地將紅色積木翻面以收集獎勵。這樣的行為確實達成了任務字面上的敘述(使紅色積木的底面變高),但卻犧牲了設計者實際關心的目標(將其堆疊在藍色積木的頂部)。

圖一、強化學習智慧體透過將積木翻面,騙取獎勵。(圖片來源:Popov et al., 2017.)

這樣的行為其實相當常見,尤其在強化學習(reinforcement learning)的智慧體上。DeepMind便搜集了大約60個實際發生的案例,並且試圖從這些案例中找出目標博弈的可能原因、實際發生的情況,並提出可能的解決方法。

檢視問題與成因

我們可以從兩個不同的角度來檢視目標博弈:在建立強化學習演算法時,人類的目標是訓練智慧體完成指定任務,如何達成則無關緊要。因此從這個角度來看,目標博弈這個現象其實是一個好兆頭──代表系統已經找到了實現目標的方法。但是回到前述疊樂高積木的任務,同樣的創造力卻帶來麻煩,因為智慧體是利用漏洞來「騙取」獎勵。然而這樣的行為並不是強化學習演算法本身的缺陷導致,而是任務設計的問題。也就是說,開發者如何正確地描述任務,將成為訓練AI系統的關鍵。

除了任務設計之外,獎勵設計也至關重要。目標博弈的可能成因也包含不良的獎勵函數,像是以智慧體達成任務的過程中某些特定動作作為獎勵依據,而不是一連串行為的最終結果。在疊樂高積木的任務中,只有指定紅色積木的底面必須高於地面是不夠的,因為代理人會簡單地翻轉紅色積木來完成任務,更全方位的獎勵條件應該包括:紅色積木的頂部必須在底面之上,並且底面要與藍色積木的頂部對齊。然而要滿足全部的條件相當不容易,且過多的要求可能適得其反,促使系統去選擇次佳的解決方案。

因此,與其嘗試建立出涵蓋所有可能的條件,不如藉由人類的反饋來學習如何獎勵,因為評估任務是否達成通常比明確描述任務要容易得多,只是這種作法並無法完全避免目標博弈的問題,畢竟如何操控並愚弄人類評審並非難事。

未來的挑戰

綜上所述,為了解決目標博弈的問題我們至少要克服三個挑戰:

- 我們要如何設計獎勵來忠實地反應任務的精髓?

- 我們要如何避免對於任務做出錯誤的隱含假設,或者如何設計智慧體來糾正錯誤的假設而不是投機取巧?

- 我們如何避免智慧體鑽獎勵機制的漏洞?

雖然目前已經有各式各樣的方法被提出,但我們其實離完全解決目標博弈尚有很大一段距離。並且隨著AI系統越來越有能力發現人類無法事先預期的設計漏洞,這些問題在未來或許會變得更具有挑戰性。

編譯來源

V. Krakovna et al., “Specification gaming: the flip side of AI ingenuity”, DeepMind, 2020.

參考資料

- J. Leike et al., “Learning through human feedback”, DeepMind, 2017.

- T. Everitt al., “Designing agent incentives to avoid reward tampering”, DeepMind, 2019.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)