鬼片?這是AI越來越聰明的表現

編譯/賴佳昀

給電腦的填空題

在文字創作上,OpenAI的GPT-3(Generative Pre-trained Transformer 3,生成型已訓練變換模型 3 )已經可以寫出完整的詩歌、短篇小說,甚至歌曲,並且讓人難以察覺其實是電腦所作。GPT-3是一個語言變化模型,其核心源自於2017年Google團隊所推出的BERT(Bidirectional Encoder Representations from Transformers,基於變換器的雙向編碼器表示技術)。據Google的說法,BERT一開始的用意是為了更好地理解使用者所輸入的關鍵字詞,以便提供更好的搜尋體驗,但卻意外地為「自然語言處理」這一領域帶來突破性的發展。在BERT之前,既有的語言模型雖然可以自動完成語詞或短句,但若想要按照文法寫出有意義的長句子,表現卻十分糟糕。

Google團隊透過大量例句,並以一種稱為「遮罩」(masking)的新方法來訓練BERT──將句子的部分字詞挖空,並要求模型填空。舉例來說:

- 有個女人去___運動。

- 他們買了一種____的麵包來做三明治。

透過不斷演練類似的「習題」(數百萬次),模型逐漸發現這些字詞是如何組成一個句子,而句子又是如何組合成一個段落。如此一來,模型不僅能生成自然、通順的文本,甚至能「更深入地」理解一段文字。

為生成的圖像加上標題

圖一、一隻______站在大樹附近的泥地上。(圖片來源:AI2)

艾倫人工智慧研究所(Allen Institute for Artificial Intelligence,AI2)的研究團隊則突發奇想,將BERT與GPT的成功經驗套用在另一種同時兼顧文字和圖像的模型,也稱為視覺語言模型(visual-language model)的開發上。事實證明這類「看圖填空」的方法十分有效。

為了完成圖一的圖片敘述,模型需要同時觀察圖片中有哪些物件,以及句子裡缺少了什麼字。經過數百萬次的練習,模型不僅可以發現字詞組成的規律,還能串起填入字詞與圖像中物件之間的關係。模型於是可以在看到圖片後給出一段貼切的說明文字(例如:圖一是「一隻站在大樹旁的長頸鹿」),或回答與圖片相關的問題(例如:長頸鹿正在做什麼?)。

一張圖勝過千言萬語

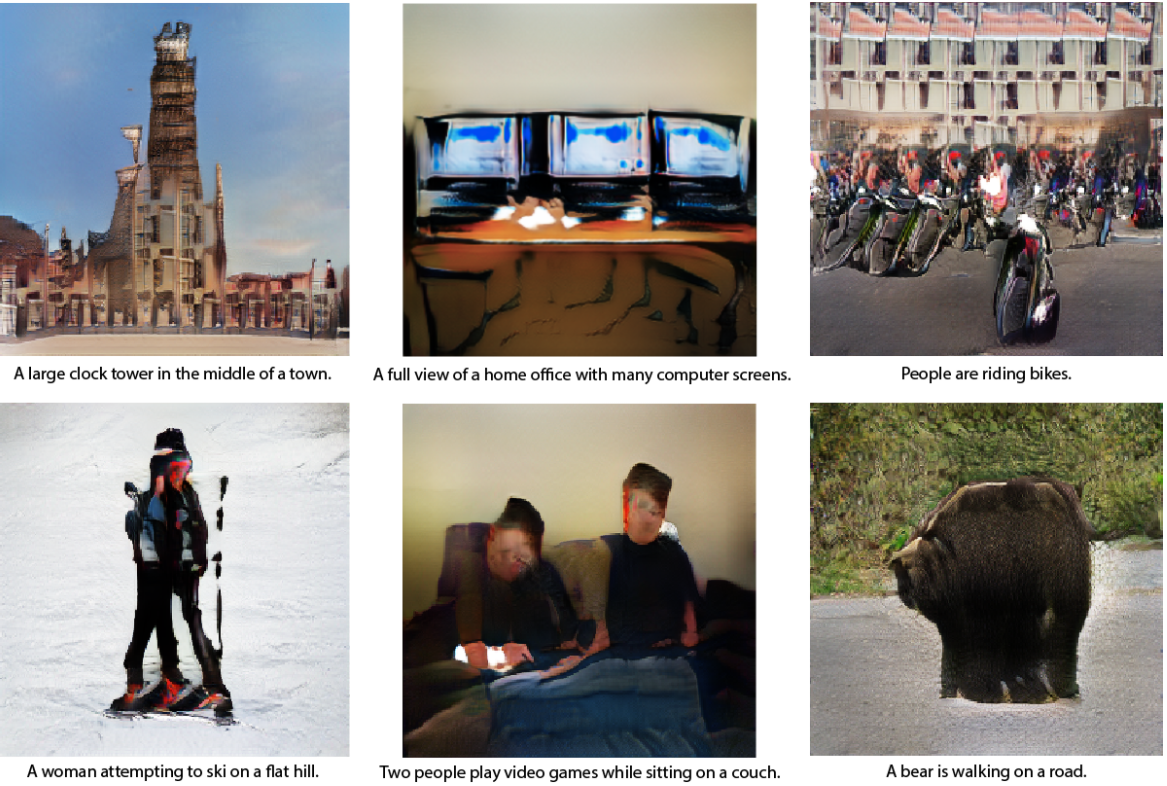

這看起來像是就像一個牙牙學語的幼兒,將所學到的新詞對上所代表的事物。然而模型「真的」理解文字的意義與所對應到的圖像嗎? AI2的研究人員於是反過來要求模型按照文字的說明生成圖像,結果如圖二所示,是一系列看似驚悚、詭異的影像。

圖二、AI2的視覺語言模型所產生的圖像。每張圖片下方的句子為研究人員給定的原始文字描述。(圖片來源:AI2)

將文字轉換成圖像本來就比較難,這是可以理解的:文字並未囊括圖像中的所有內容,因此模型還需要學習其他有關這個世界的知識,來彌補文字沒有特別提到的細節。舉例來說,請畫出「一隻長頸鹿在路上走」,那麼模型就需要自行推論出這條路可能是灰色,而非粉紅色,周圍可能是一片草地,而非茫茫大海。這樣一來,教導模型生成與說明文字相對應的圖像,所「遮罩」的就不能只是說明文字了,而是遮罩圖像,讓模型去補足圖像中缺失的部分。

一開始生成的圖像可能不夠真實,但就像我們小時候先是用火柴人勾勒出人物的骨幹,然後才學會如何添加更多的細節。視覺語言模型用這種方式來學習生成圖像,表示AI開始用一種比較抽象的方式來理解這個世界,並能用語言表達其身所處的環境。

編譯來源

K. Hao, “These weird, unsettling photos show that AI is getting smarter“, MIT Technology Review, 2020.

參考資料

Allen Institute for AI, “Computer Vision Explorer“, 2020.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)