讓機器能夠學習的「標準答案」是怎麼來的?

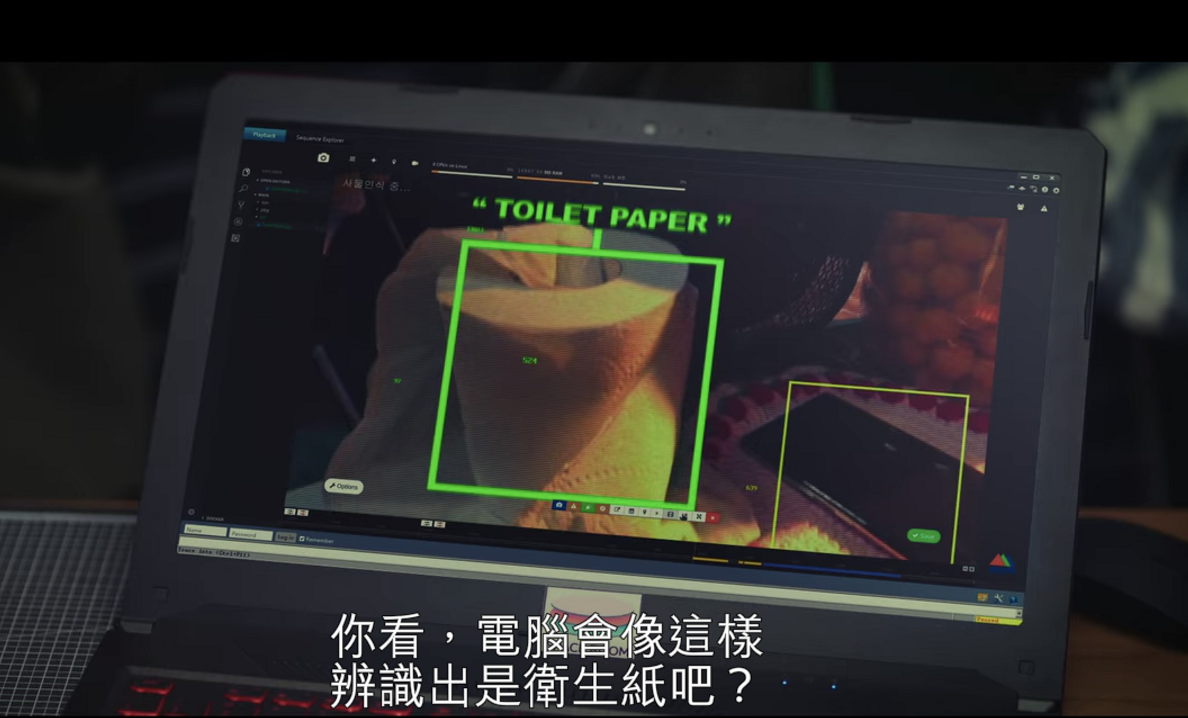

近年來經常聽到的臉孔辨識、表情辨識、圖像辨識背後所仰賴的就是機器學習技術,讓電腦像小孩一樣學習辨識生活中各種不同的事物。在韓劇《我的新創時代》(Start-up) 中,男主角南道山帶領的團隊在做的就是讓電腦學會辨識生活周遭的物體,當它把攝影機拍向房間,電腦就可以判斷出畫面中出現的是泡麵、衛生紙、還是人臉。這個電腦視覺(computer vision)技術被應用在各種不同的自動化服務裡,像是如何讓自駕車判斷其他車輛以及斑馬線、讓電腦自動辨識手寫文件上的內容、協助盲眼朋友辨識環境、上傳照片的時候直接標出人臉的範圍並給你幾個可以參考的tag或是告訴你照片中的人是男生還是女生,年齡幾歲。要讓電腦具備這些辨識能力,需要有什麼資料才能做到呢?

撰文/楊期蘭

●辨識之前需要先標記內容

如同在教小孩辨識物品一樣,當我們要讓小孩認得狗,當狗出現的時候我們就會指著狗跟他說這是狗,看到不同種類的狗我們都會教他:這是狗,隨著他看得越來越多,下次看到新的狗就能辨識出來;換到教電腦的情況下,這個「告訴他什麼是一隻狗的過程」我們就稱作「標記」(labeling),有些情況下還會需要現在畫面上畫出範圍(bounding box),讓電腦知道畫面中的哪個位置被標記了一隻狗。舉例來說,當我們要在街景圖上標出不同種類的車輛,就需要先畫出一台車的範圍,再給他一個標記。這些標記就成了電腦學習如何辨識不同物體的「標準答案」。

這些標記的工作看起來很簡單但是繁瑣,所以大部分在做電腦視覺技術的公司會將這些標記工作外包給專門協助標記各種圖像資料的公司,而這些公司也通常位於低勞動成本的國家,或是經常雇用領最低薪資的工讀生 [5, 6] 或是在當地屬於低社經地位的群組,包含外籍移工、教育程度較低的勞動者。

●隱藏在客觀中立機器背後的主觀性

根據2020年發表在人機互動領域頂尖研討會的一項研究 [1],研究人員透過進入這些資料標記公司進行田野調查 (field study) 以及深度訪談這些資料標記者、審查標記者、專案負責人以及負責電腦視覺技術開發的工程師,發現在資料標記的過程中不對等的權力關係以及商業利益導向的作業流程會大大影響這些被用來當作電腦學習標準答案的基礎。

●不對等的權力關係:怎麼標記由工程師說了算

整個外包標記資料的過程這樣的:負責電腦視覺的技術公司發包給外包公司,接著外包公司們會有一個計畫負責人向底下負責標記每筆資料的標記者說明要畫出什麼範圍、要標記什麼東西、有哪些分類,而通常因為各種商業保密的原則,外包公司們不一定能知道資料被標記的明確用途。舉例來說:當被要求標記影片中的車輛損壞範圍、損壞程度、車輛種類時,損害範圍涵蓋的大小如何界定?如何定義損壞程度?校車跟公車算不算同一個類別?計程車跟家用車差別在哪?每個決定其實都包含了資料標記者、專案負責人、技術團隊的主觀性。

在研究者們的研究中發現外包團隊經常出現的問題是資料標記者(也就是標準答案的產生者)對資料最後的用途不了解,因此當出現難以標記或歸類的情況時,能做的就是一層一層往上詢問,標記者問審核標記的人,審核標記的人問專案負責人,專案負責人問發包科技公司的工程師。最後,具有爭議的標記(標準答案)會由出錢公司的工程師決定。由誰決定應該怎麼標記並沒有問題,問題出在這些決定的過程沒有被記錄下來,因此未來使用這些被標記資料庫的使用者也無從得知這些標記是在什麼背景下產生、如何決定的。舉例來說,可能會出現的爭議狀況就是決定標記的人覺得以下的車況是輕度損壞,但是可能有其他人覺得這是中重度損壞。這種情況未來可能會出現問題的情況是,若果保險公司處理車禍理賠的人不了解這些資料標記的過程,就會完全相信系統的判斷,導致誤判狀況的可能。

●商業利益導向的作業流程:時間壓力下給出高效率標記的後果

由於外包公司為了爭取更多標記資料的機會,他們會想辦法找出「統一且標準化」產出標記的方式,然後由資料標記團隊揣測發包公司的人的目的,接著自己決定所有分類跟標記的種類,嘗試用最少的時間給出符合對方目標的分類。研究也發現通常發包公司不願意提供額外資源重複確認標記的正確性,也不會花心力特別處理標記資料延伸的的相關倫理議題。

舉例來說,在這次研究中的其中一個專案是被要求分類不同的臉孔,標記者收到的指示是在不同的臉周圍畫出長方形的範圍 (bounding box),接著給出以下類別:男性/女性;年齡(0-2歲大的嬰兒、2-16歲的男孩或女孩、16-65歲的男人或女人、65歲以上的老人);種族:高加索人、日本人、韓國人、中國人、拉丁美洲人等。想像你是負責標記的人,當你看到一張照片的時候,你是根據哪些線索判斷一個人的年齡跟族裔?你的成長經驗、文化背景、價值觀帶給你的判斷會跟另一個標記者一樣嗎?

●重視資料標記過程中人類勞動力的價值

這些被標記的資料是所有人工智慧應用的基礎,當這些標記被用在幫助加快辨識通過收費站的車輛為何、或是幫助盲眼人辨識周遭障礙物的時候都是改善大家生活品質的應用,但是如果當這些智慧辨識技術被用在監控系統上辨識特定人物、辨識求職者的情緒狀態、辨識一個人的身分等,這時候訓練機器判斷規則的標記(標準答案)怎麼產生就十分重要。

從這篇我們可以知道資料標記的整個過程中其實存在著許多主觀性以及難以清楚界定標記分類的情況,身為直接使用這些智慧系統服務的個人,我們能做的就是提醒自己留意這些電腦所學習的標準答案可能存有偏見,當我們被電腦分類、辨識成一個自己覺得滿意的類別時很容易覺得這些智慧系統「神準」,但是也很有可能有一天我們不小心被有偏見標記訓練出來的模型辨識成一個自己不想成為的類別,如果我們一直忽視資料標記過程中每個環節的主觀性,這些小小的偏見就會被藏在看似中立客觀的機器裡,累積起來讓我們成為偏見的受害者,或甚至強化人類社會的偏見。

而身為機器學習相關技術的開發者,這篇研究想呼籲的就是鼓勵我們重視這些機器學習「標準答案」的產生過程,在使用資料集(dataset)的時候要清楚紀錄它原本標記的使用目的為何?標記方式包含哪些?如何產生不同標記類別?有誰決定這些標記等,當資料集的提供者與使用者都清楚知道這些標記的相關脈絡,我們才能避免教出一個放大某些偏見的機器。想像這就是你的孩子,任誰都不會希望自己的孩子從小到大只學習非常簡化的分類以及在單一價值觀底下成長吧?

| 附註:目前已有兩個機器學習領域的國際頂尖研討會(NeurIPS, ICML) 已經開始要求研究者們在投稿與資料集相關(Dataset)研究時,需要附上資料標記的產生細節以及標記過程中提供給資料標記者的指示,藉此讓其他使用這些資料集的研究者或實務工作者們更清楚了解資料搜集的目的以及資料標記的脈絡。[2, 3, 4] |

作者:東京大學 學際情報學 楊期蘭 (搜尋「人機共生你我它」了解更多)

參考資料:

- Miceli, M., Schuessler, M., & Yang, T. (2020). Between Subjectivity and Imposition: Power Dynamics in Data Annotation for Computer Vision. Proceedings of the ACM on Human-Computer Interaction, 4(CSCW2), 1-25.

- ICML 2020 Style & Author Instructions

- NeurIPS 2020

- The Machine Learning Reproducibility Checklist (v2.0, Apr.7 2020). https://www.cs.mcgill.ca/~jpineau/ReproducibilityChecklist.pdf

- 資料標註工讀生/實習生(圖像/語音/文字等標註)|竹間智能科技有限公司|台北市內湖區-104 人力銀行.

- AI資料標註與測試 工讀生|昱冠資訊股份有限公司|新竹市-104 人力銀行.