手語辨識─聽障人士也能使用的家庭智慧助理

編譯/葛竑志

語音助理熱潮

近年來,傳統上藉助打字或手寫的人機互動方式已逐漸式微。在這樣的趨勢下,各大科技龍頭如Amazon、Google與Apple也紛紛推出了自家的語音智慧助理,期待能在廣大的潛在市場中占得先機。根據美國國家公共廣播電台與Edison市場研究公司的一項調查報告指出:截至2017年底,每六位成年人就有一位擁有智慧助理,近四成的人更表態願意為了智慧家電而添購[2]。調查也顯示,智慧型助理已逐漸取代傳統收音機、手機與電視,成為人類的科技新歡,顯示大眾已經越來越能接受這種新型態的科技互動模式。

但在這股熱潮之中,先天聽障者往往淪為被忽略的一群。由於聽力受損,幼時的他們無法如常人般,藉由反覆聆聽與模仿來訓練發音與咬字,所說的話語也因此經常難以被現有的語音辨識系統所辨識。然而,既然智慧語音助理的市場定位是要成為每個家庭的必備工具,那便應該完全融入人們的生活,考量到所有人的需求與困難。畢竟,科技,始終要和人性無縫接軌。

其實並不困難

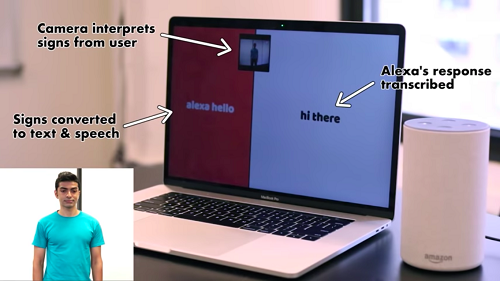

出乎意料的,以現有的技術而言,手語辨識並不困難。Singh僅利用TensorFlow自行在筆電上寫了一套深度學習架構,將一些手語影片與對應的文字送到模型中,以訓練機器如何將一連串的手語動作轉換成文字。最後借助google小姐的幫助,將句子朗讀予Amazon Echo(語音助理),而Echo的回答也能自動轉換為文字,供聽障者理解。「靠著一台筆電就能完成這些事,對那些具備攝影機和螢幕功能的語音助理來說,沒道理不能做到這件事情吧?」Singh如此說道。

並非沒有先例

其實早在2013年,Microsoft便已發表了一篇針對手語辨識可行性的評估報告[3]:藉由自家產品Kinect的深度影像與追焦功能,機器可以精準判讀手部動作,並透過機器學習理解所表達的意義。然而,隨著Kinect停產,相關發展也因此沉寂了一陣子。直到2017年,知名視覺運算技術領導廠商Nvidia,於GTC大會上發表了即時手語辨識技術[4],在Seq2Seq架構下,得力於繪圖處理器 ( GPU ) 在運算速度上的幫助,實現即時手語字幕的可能。

然而,卡內基梅隆大學人機互動專家Jeffrey Bigham認為:無論是輸入端的電腦視覺技術,還是輸出端的語言處理,現有的手語辨識系統難稱完備。即便是Alexa,仍只能解讀片段語意,算不上真正理解一種語言。除此之外,有別於一般既定印象,手語不僅止於手部動作,更包含了過程中所有的肢體動作與臉部表情。

英國聾啞協會Aine Jackson則對此抱持樂觀態度,並冀望於如Singh這樣的人,在語音辨識的發展如日中天時,仍願意發揮自己的創意與想像力,顧及如聽障者等小眾被忽視的訴求。不僅是透過影像辨識,其他如能直接感測手部動作並讀取手語的手套,或將文字透過虛擬角色以手語表達的軟體,在在都是他們的用心與巧思。

編譯來源

“Alexa hacked to grasp sign language”, BBC News, 2018.

參考資料

- The Smart Audio Report, National Public Media, 2017.

- Kinect Sign Language Translator, Microsoft Research Blog, 2013

- Samantha Zee, Whose Sign Is It Anyway? AI Translates Sign Language Into Text, Nvidia Blog, 2017

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)