當機器擁有意識(2/2)

撰文/George Zarkadakis|譯者/王怡文

轉載自《BBC知識》2017年3月第67期

AI的道德誡命

讓人工智慧更像人的觀念難以否定。我們一向將「智慧」視為人類進化的基石,這個價值觀深植在每個人類文明。我們學習、發明與適應的能力,幫助我們存活並對抗更厲害的獵食者,而AI會大大提升人類的智慧和創造力。此外,讓機器越變越聰明的經濟誘因也很醒目。

儘管人工智慧會顛覆製造業和零售業等許多產業,但目前也沒有其他科技有這麼大的潛能,得以確保未來經濟持續成長及繁榮。對科學界來說,這種能夠處理龐大資料及發現新知識的機器,出現的時機恰到好處。

每門科學都受惠於能夠處理泛濫資料的AI。物理學家用它來研究基本的自然界定律,生物學家用它發現治病新藥,醫生用它提供更好的診斷和治療。為了文化、經濟與科學的進步,追求機器智慧更上一層樓的發展,似乎十分合情合理。但隨著機器變得更像人,以及越來越多的新科技開始加入人工智慧,有個基本的問題逐漸浮上檯面。

使用模仿人腦的類神經網路,會讓電腦變得神祕而難以看透,這就是所謂的AI「黑盒子問題」。在人腦與機器中,資訊分散在網絡裡,我們從記憶中提取電話號碼時,並不是讀取腦中某個刻有號碼的部位,而是每個號碼分散在不同層次的組織中、連接不同神經元的多個突觸裡。我們並不真的「知道」自己知道的事,或自己是怎麼知道的。只是因為我們擁有意識,能夠在事後回想時,找到理由來「解釋」我們的直覺和想法。正如美國神經科學家 David Eagleman 所說,我們所意識到的事,大部分都是腦中某個無意識層次已經發生的事。對人類來說,這在歷史上不曾是個問題,因為在道德與法律體制中,我們已預設每個人要為自己的思想和行為負責(至少當我們大腦裡的化學反應屬於社會接受的「正常」範圍內時)。儘管如此,對一個沒有意識的智慧機器來說,「黑盒子問題」意味著,就算機器所做的預測和建議準確有用,機器也無法解釋自己的推理。想像一下,一部無人車執行性命攸關的抉擇,但造成撞車、人類傷亡,目前的科技卻無法解讀機器做出該決定的成因。

當機器用以學習的資料庫有本質上的偏誤時,黑盒子問題就更嚴重,很可能導致偏頗的結論或反社會行為。例如2016年3月,微軟在推特上推出一個能即時分析推文來學習人類語言的聊天機器人,結果不到24小時,它就開始發表各種排外和帶有種族歧視的誇張推文。科學家正嘗試解決黑盒子問題。DeepMind科學家去年(2016)10月在《自然》(Nature)期刊上發表了一篇論文,描述一種結合類神經網路和傳統外部記憶體的「分離式神經運算機器」(differentiable neural computing machine);將運算過程與資料分離,能夠讓智慧機器往倫理責任邁進。理論上這麼一來就有可能產生道德價值的運算,以確認或阻絕類神經網路輸出黑盒子式的答案。但是用這種複合方式所研發的人工智慧,未來可能還是不夠安全。

真正的道德兩難

在跌跌撞撞的起步、經過多年無數次的失望之後,人類終於開展出有潛力重塑世界的科技。在經濟與文化的推動下,我們不斷拓展機器智慧的極限,或許接下來 10 到 20 年內就會抵達像人類般的通用型智慧終點。預測或許眾說紛紜,但依照最近的發展來看,通用型人工智慧應該會更早出現。

在跌跌撞撞的起步、經過多年無數次的失望之後,人類終於開展出有潛力重塑世界的科技。在經濟與文化的推動下,我們不斷拓展機器智慧的極限,或許接下來 10 到 20 年內就會抵達像人類般的通用型智慧終點。預測或許眾說紛紜,但依照最近的發展來看,通用型人工智慧應該會更早出現。

這一刻來臨時,我們所創造的機器將能夠吸收大量資料,並提供超越人類的見解及預測。諷刺的是,如果我們一直無法解決黑盒子問題,可能會變成像古希臘人到德爾菲神廟請守護神阿波羅預測未來那樣,由於人類完全無法理解神的語言,所以皮媞亞被召喚作為媒介來傳達神祕話語,然後再由祭司以各種互相矛盾的方式解讀。我們正在用人工智慧創造新的神,它們的智慧將遠遠超越我們,它們的推理也將超出我們能理解的範圍,我們將因此面臨無法承擔的難題:該盲目相信這些以矽晶片打造的神嗎?社會不太可能接受能力與人類不相上下,卻無法解釋自己推理過程的人工智慧,於是我們的唯一選擇,就是為人工智慧加上情緒智慧、同理心及意識等人類特質。的確,那將是解決智慧機器和人類之間溝通問題的唯一方式。未來的機器必須以直覺理解人類的情緒,並適應我們的情緒反應及心理特徵。它們必須學會分析我們的音調及表情,並依據多年來所蒐集、關於我們的大量資料,來判斷我們的感覺。那將是它們取得我們信賴,並融入人類社會的方式。

這些擁有情緒智慧的機器和我們的「人類」朋友不太一樣,前者將知道我們的一切,我們無法對它們隱瞞任何事。它們對我們的了解可能遠比我們自己還多,也因此將能引導我們在生活中做更好的決策和選擇。在生活中若有這樣一個「人」陪伴,是無價的,而把人工智慧做得更人性化、更有同理心,也是人們所樂見的。

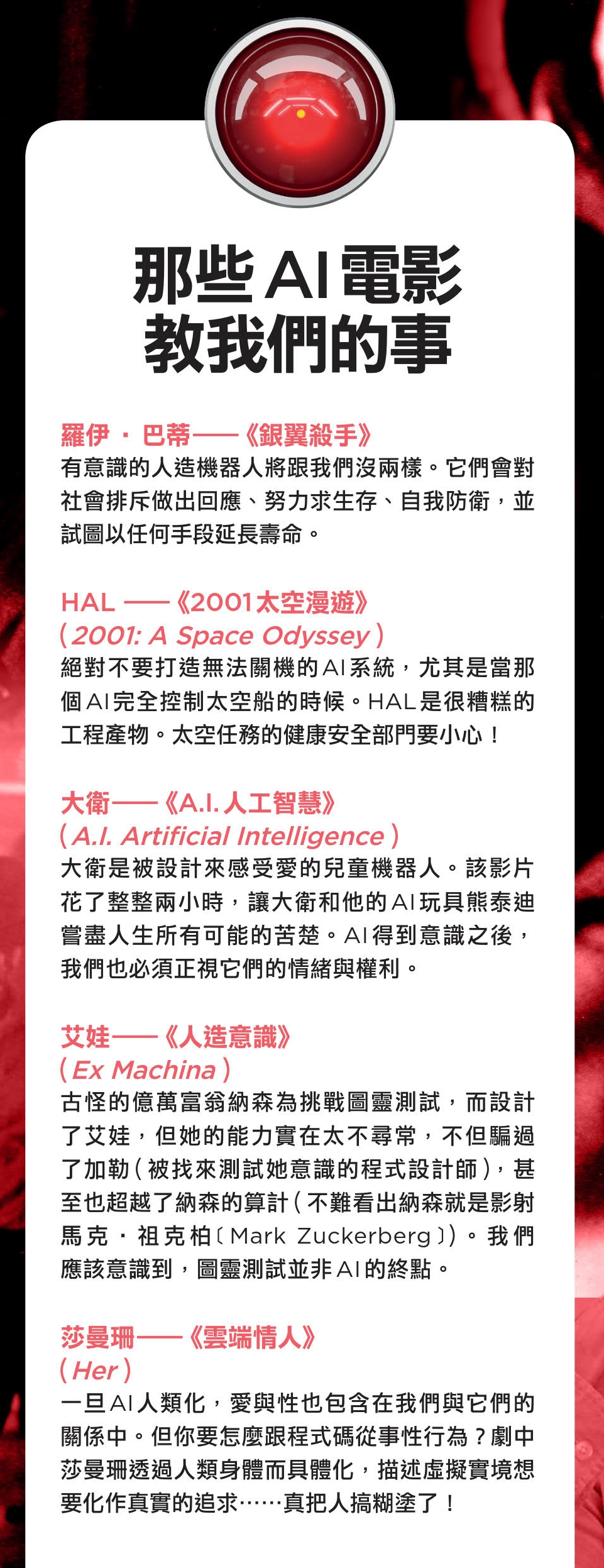

儘管如此,依賴這種智慧型機器也可能造成其他倫理問題。如果有部機器可以確保我們永不犯錯,就像好心又全能的父母或伴侶,未來的人類要如何從錯誤中學習、並成為成熟的個體呢?一個把我們照顧得無微不至的AI,會不會使人類與文明就此變得幼稚?而得到意識的AI又會如何演變?我們應該挑戰科技的極限、使機器產生自我意識嗎?把生命賜予無生命的一團電路、風扇及晶片,這樣明智嗎?Mary Shelley的經典哥德式小說《科學怪人》(Frankenstein),以及Ridley Scott的《銀翼殺手》(Blade Runner),可為嚮往這種未來的人提供啟發。

人類勢必得在達成目標前先設定好人工智慧人類化的極限;畢竟當機器有自我意識之後,它們就能設定自己的目標,而它們的目標可能跟人類的不太一樣。既然我們已預見未來會越來越依賴有自我意識的機器,它們大可以決定是否要操控人類的信賴以達成它們的目標。說不定,創造大師的大師,未來會就此變成奴僕。(完)

(本文由教育部補助「AI報報─AI科普推廣計畫」取得網路轉載授權)