偏差的模型比想像中致命

編譯/劉大維

性命攸關

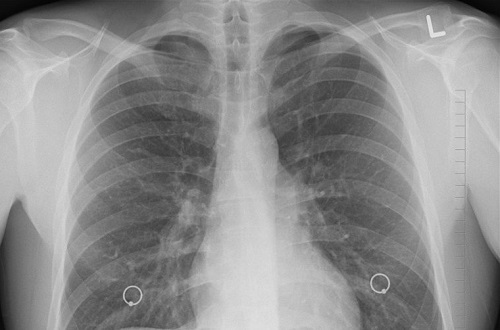

人工智慧的應用層面五花八門,而其在醫療領域的發展可說最為蓬勃熱門。用來進行電腦輔助診斷與影像篩檢的AI系統,已經在全世界各地的醫學中心得到廣泛的採用。而由此衍生的一個首要議題就是:經訓練所得到的AI,其分類依據與結果是否公正或存在偏差,因為這會直接影響模型的成效,在醫療領域更是攸關患者健康、性命的事情。美國國家科學院院刊(PNAS)日前刊登了一篇論文,研究團隊使用性別比例懸殊的病患胸部X光片來訓練機器,結果發現得到的模型在診斷上的成效表現較差。

研究採用Inception-v3、ResNet和DenseNet-121三種神經網路架構,訓練資料則來自於史丹佛大學和國家衛生研究院(NIH)的胸腔X光片資料庫。兩個開放平台所收錄的原始資料雖然性別比均衡,但經研究團隊人為調整後,建立了五組不同的訓練資料集(男女組成比例分別為0、25%、50%、75%、100%)。網路各自經由不同的資料集訓練過後,再以男女混雜的X光片資料進行測試,結果發現性別比例越扭曲的資料集所訓練出來的模型,其診斷準確度越糟。有趣的是,模型並不會因為訓練資料中特定性別比例較高,而針對該性別有較高的準確度。也就是說,不論男女,訓練資料集中被放大(over-represented)的性別並不會因此受惠。

偏差的成因

造成這樣的結果原因還不明確,有可能是生理差異,也可能是各種社會和文化因素造成。舉例來說,女性相較於男性,在疾病發展的各個階段,都更有意願接受X光攝影。也就是說,資料的收集本身可能就存在偏差,研究人員得從源頭把關。

因為訓練資料偏差所造成模型的偏差,可能導致不合宜的分類結果,甚至完全與事實不符。如此一來,AI不僅無法輔助人類,更成了扯後腿的腳色,尤其在醫療領域中,這更會將患者的性命置於危險之中。

然而,有時醫療或研究人員是「不得不使用」帶有偏差的資料,例如乳癌病患的資料通常以女性為大宗。同樣地,自閉症的發生率有性別差異,男孩確診的比例硬是比女孩高出許多。

種瓜得瓜

在現實世界中,人類需要借助AI之處除了相對單純的醫療影像判讀,經濟發展、危機管理、天氣預測等,皆須仰賴各種訊息載體產生即時且連續的資訊流,其中當然也可能存在偏差不均的情形,我們又該如何處理與使用這些資料來訓練出理想的AI模型呢?

一個典型的機器學習系統通常是由資料預處理單元、模型建置器、評估單元及輸出單元所組成。處理資料不平衡的方法可以從三個層面著手:資料層面、演算法層面以及前兩者的混合,也就是從收集的資料著手(取樣手段、資料合成、資料加權及分類方法等等)、修改/更換演算法或是雙管齊下。因此可以看出,要得到理想模型,關鍵還是在前端訓練資料的處理(當然,視情況對分類器輸出結果進行調整與補償也是方法之一)。

如果把AI比喻為一艘船,水就是大數據。水能載舟,亦能覆舟。如何讓AI這艘船在數據大海中航向我們設定的目標,是當前每位AI研究者的要務。

編譯來源

D. Nelson, “AI Models Trained On Sex Biased Data Perform Worse At Diagnosing Disease“, Unite.AI, 2020.

參考資料

- A. Larrazabal, N. Nieto, V. Peterson, D. Milone and E. Ferrante, “Gender imbalance in medical imaging datasets produces biased classifiers for computer-aided diagnosis“, Proceedings of the National Academy of Sciences, vol. 117, no. 23, pp. 12592-12594, 2020.

- B. Krawczyk, “Learning from imbalanced data: open challenges and future directions“, Progress in Artificial Intelligence, vol. 5, no. 4, pp. 221-232, 2016.

(本文由教育部補助「AI報報─AI科普推廣計畫」執行團隊編譯)